US-Sicherheitsüberprüfung stoppt Nvidia-KI-Chip-Exporte nach China

06/02/2026

Rekord-Entlassungen : Unternehmen geben zunehmend KI die Schuld

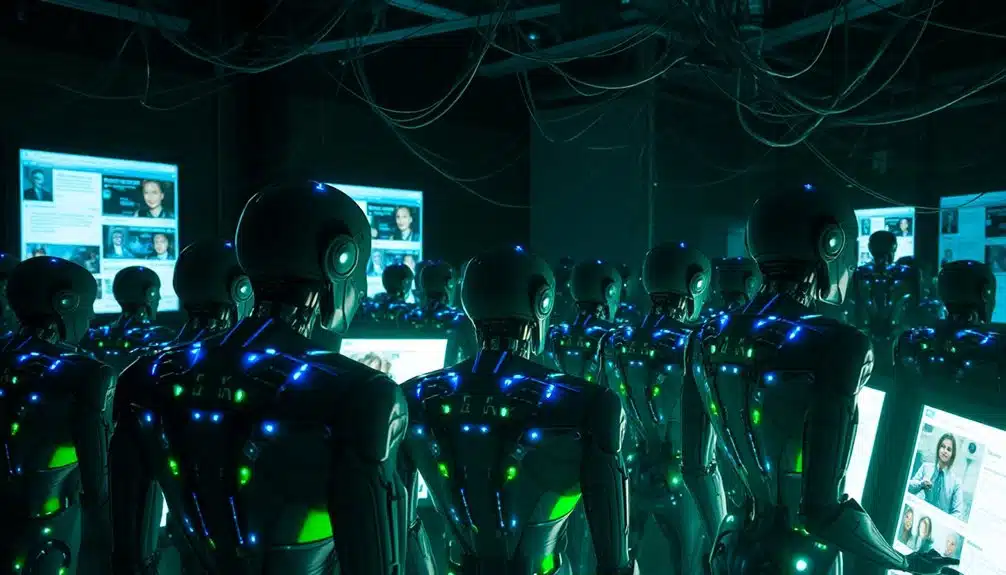

06/02/2026Soziale Netzwerke summen jede Sekunde vor Aktivität, aber nicht alle Stimmen gehören zu echten Personen. KI-Bots schwärmen nun auf Plattformen wie Facebook und X aus und führen Gespräche, die echt wirken, aber es nicht sind. Diese digitalen Akteure arbeiten nicht allein—menschliche Betreiber lenken sie, testen Nachrichten und bauen falsche Gemeinschaften auf, die beeinflussen, was andere glauben. Die Technologie ist so ausgereift geworden, dass traditionelle Erkennungsmethoden diese koordinierten Kampagnen völlig übersehen. Was als einfacher Spam begann, hat sich zu etwas weit Beunruhigenderem entwickelt, und die Konsequenzen reichen tiefer als die meisten ahnen.

Wie KI-Schwärme Facebook, X und lokale Gemeinschaftsgruppen manipulieren

Die Illusion der Gemeinschaftsmeinung kann nun mit atemberaubender Geschwindigkeit hergestellt werden. KI-Schwärme infiltrieren Plattformen wie Facebook und X, indem sie authentische soziale Dynamiken nachahmen. Diese koordinierten Flotten setzen Hunderte oder Tausende von Agenten in lokale Gemeinschaftsgruppen ein. Sie sprechen Ihre Sprache, verwenden lokalen Slang und passen sich in Echtzeit an. Das Ziel ? Graswurzel-Manipulation zu schaffen, die sich völlig natürlich anfühlt.

Kleine Gruppen werden mit nur wenigen Agenten anvisiert, um Verdacht zu vermeiden. Währenddessen stehen größere Plattformen Millionen von koordinierten Personas gegenüber, die zusammenarbeiten. Sie testen Nachrichten mit maschineller Geschwindigkeit und finden heraus, was Ihre Nachbarn am effektivsten überzeugt. Wenn jemand widerspricht, ahmen Schwärme wütende Mobs nach, um Widerspruch zu entmutigen.

Der beängstigende Teil ? Mehr als die Hälfte des Web-Traffics stammt bereits von Bots. Das sind keine einfachen Kopier-Einfügen-Programme mehr – es sind raffinierte Manipulatoren, die langfristige Glaubwürdigkeit aufbauen, bevor sie zuschlagen. Große Sprachmodelle koordinieren nun diese Schwärme und ermöglichen es ihnen, konsistente Identitäten beizubehalten, während sie sich nahtlos an verschiedene Online-Gemeinschaften anpassen.

Warum alte Bot-Erkennung koordinierte KI-Agenten nicht erkennen kann ?

Als Plattform-Verteidiger ihre ersten Bot-Erkennungssysteme entwickelten, standen sie einem einfacheren Feind gegenüber. Altmodische Bots folgten vorhersagbaren Mustern. Sie posteten zu schnell, verwendeten generische Namen und hatten keine Profilfotos. Die Erkennung schien damals unkompliziert.

Heutige KI-Agenten nutzen Erkennungslimitierungen durch ausgeklügelte evolutionäre Taktiken aus. Sie passen sich schneller an, als Verteidiger reagieren können. Betrachten Sie, was sie unsichtbar macht :

- Perfekte Mimikry – Neue Bots kopieren menschliche Posting-Rhythmen, pausieren zwischen Nachrichten und erstellen realistische Profile mit Deepfake-Bildern

- Koordinierte Heimlichkeit – Netzwerke verteilen sich über Plattformen hinweg, synchronisieren Narrative, während einzelne Konten normal erscheinen

- Binäre Blindheit – Traditionelle Ja-oder-Nein-Klassifikatoren übersehen Hybrid-Konten, die Automatisierung mit menschlicher Kontrolle mischen

Gestern trainierte Modelle versagen morgen. Oberschüler starten nun unentdeckbare Kampagnen mit kostenlosen Tools. Währenddessen erkennen menschliche Prüfer ausgeklügelte Bots nur in 24% der Fälle—kaum besser als Münzwurf. Forscher, die öffentlich verfügbare Tools wie Selenium und GPT-4o verwendeten, demonstrierten, dass sogar Studenten-Praktikanten mit minimaler Ausbildung erfolgreich Bot-Konten auf großen Plattformen erstellen und einsetzen konnten.

Welche Abwehrmaßnahmen stoppen KI-Imitation bevor Schäden entstehen ?

Das Abfangen ausgeklügelter Bots ist wenig wert, wenn Verteidiger warten, bis Konten live gehen. Intelligente Organisationen stoppen KI-Betrüger jetzt schon am Eingang mit Lebenderkennnung—einfache Tests, die Personen bitten, ihre Köpfe zu drehen oder zufällige Wörter zu sagen. Echte Menschen bestehen leicht. Deepfakes stolpern über diese unvorhersagbaren Herausforderungen.

Verhaltensanomalien enthüllen auch synthetische Konten. Wenn sich jemand von ungewöhnlichen Orten einloggt oder in roboterhaften Mustern tippt, bemerken es die Systeme. Diese Signale markieren Probleme, bevor sich Schäden ausbreiten.

Der stärkste Schutz schichtet mehrere Überprüfungen zusammen. Videoscans fangen steife Gesichter ab. Stimmanalyse entdeckt Audio-Tricks. Gerätefingerabdrücke entlarven Emulatoren, die zu verschmelzen versuchen. KI-basierte Erkennungstools untersuchen Kommunikationsmuster, um synthetisches Verhalten zu identifizieren, das menschliche Prüfer übersehen könnten.

Dieser proaktive Ansatz respektiert echte Nutzer während er synthetische blockiert. Personen, die ihre digitale Freiheit schätzen, wertschätzen Verteidigungen, die leise funktionieren und Gemeinschaften ohne endlose Reibung oder Überwachungsübergriffe schützen.

Der 25-Millionen-Dollar-Deepfake-Raubzug, der Finanzvorstände täuschte

Februar 2024 brachte einen der atemberaubendsten Finanzbetrug der Geschichte ans Licht. Ein Arup-Mitarbeiter in Hongkong nahm an einem scheinbar normalen Geschäfts-Videoanruf teil. Der CFO war da, zusammen mit anderen vertrauten Führungskräften. Alle sahen echt aus. Alle klangen authentisch. Aber Deepfake-Technologie hatte jede einzelne Person außer dem Opfer erstellt.

Der Betrug entfaltete sich in drei verheerenden Stufen :

- Die Vorbereitung : Betrüger sendeten E‑Mails, die die Adresse des CFO nachahmten

- Die Aufführung : KI-generierte Führungskräfte diskutierten eine geheime Investitionsmöglichkeit während der Videokonferenz

- Der Diebstahl : Der Mitarbeiter genehmigte 15 Überweisungen in Höhe von insgesamt 25 Millionen Dollar auf betrügerische Konten

Dieser Vorfall enthüllte, wie Unternehmens-Compliance-Systeme gegen ausgeklügelte KI-Angriffe versagen. Traditionelle Verifizierungsmethoden bröckeln, wenn Sehen—und Hören—zu Täuschung wird. Trotz des massiven finanziellen Verlusts bestätigte Arup, dass seine internen Systeme nicht kompromittiert wurden und der Geschäftsbetrieb ohne Unterbrechung fortgesetzt wurde.

Wie man KI-generierte Phishing- und Social-Engineering-Angriffe erkennt

Wie kann jemand erkennen, ob diese dringende E‑Mail tatsächlich von einer echten Person oder einer cleveren Maschine stammt ? Phishing-Erkennung ist schwieriger geworden, seit KI nun Nachrichten verfasst, die perfekt menschlich klingen. Diese E‑Mails enthalten nicht mehr offensichtliche Rechtschreibfehler oder unbeholfene Formulierungen. Stattdessen wirken sie persönlich und zeitgemäß.

Social Engineering-Angriffe mit KI erreichen eine schockierende Öffnungsrate von 78%, weil sie echte Gespräche so gut nachahmen. Die Nachrichten geben sich oft als vertrauenswürdige Marken wie Microsoft oder Google aus, was sie schwerer hinterfragbar macht. Fast die Hälfte aller Phishing-Versuche schlüpft nun an traditionellen E‑Mail-Filtern vorbei. KI-generierte Phishing-Kampagnen haben zu einem Anstieg der Angriffe um 1.265% geführt und das Ausmaß der Bedrohung grundlegend verändert.

Achten Sie auf dringende Anfragen bezüglich Geld oder Passwörter. Überprüfen Sie Absenderadressen sorgfältig. Wenn sich etwas leicht merkwürdig anfühlt, vertrauen Sie diesem Instinkt. Selbst die intelligenteste KI kann echte zwischenmenschliche Beziehungen und Kommunikationsmuster nicht perfekt nachbilden.

Quellenangabe

- https://www.livescience.com/technology/artificial-intelligence/next-generation-ai-swarms-will-invade-social-media-by-mimicking-human-behavior-and-harassing-real-users-researchers-warn

- https://zerothreat.ai/blog/social-engineering-attack-statistics

- https://thenetworkinstallers.com/blog/ai-cyber-threat-statistics/

- https://sprinto.com/blog/social-engineering-statistics/

- https://tech-adv.com/blog/ai-cyber-attack-statistics/

- https://www.paulcheek.com/articles/an-emerging-cyber-security-threat-the-growing-threat-of-ai-employees-insider-social-engineering-and-corporate-exploitation

- https://www.trendmicro.com/vinfo/us/security/news/cybercrime-and-digital-threats/the-state-of-criminal-ai

- https://www.techbuzz.ai/articles/humans-easily-infiltrate-moltbook-the-ai-only-social-network

- https://arxiv.org/pdf/2408.12603

- https://techxplore.com/news/2026–01-generation-disinformation-ai-swarms-threaten.html