Die Welt der Feen

31/03/2023

Die Job_Id in Midjourney | Discord finden

31/03/2023Die KI steht nicht kurz davor, ein Gefühl zu entwickeln – die wahre Gefahr liegt darin, wie leicht wir dazu neigen, sie zu vermenschlichen

Fühlt die KI ? Unsere Tendenz, Maschinen als Menschen zu betrachten und uns an sie zu binden, deutet auf reale Risiken einer psychologischen Verstrickung mit KI-Technologie hin.

Von Nir Eisikovits, Professor für Philosophie und Direktor des Applied Ethics Center, UMass Boston

ChatGPT und ähnliche große Sprachmodelle können überzeugende, menschenähnliche Antworten auf eine endlose Reihe von Fragen geben – von der Frage nach dem besten italienischen Restaurant der Stadt bis zur Erklärung konkurrierender Theorien über die Natur des Bösen.

Die unheimliche Schreibfähigkeit der Technologie hat einige alte Fragen aufgeworfen, die bis vor kurzem noch in den Bereich der Science Fiction verbannt waren, nämlich die nach der Möglichkeit, dass Maschinen ein Bewusstsein oder eine Empfindungsfähigkeit entwickeln.

Im Jahr 2022 erklärte ein Google-Ingenieur, nachdem er mit LaMDA, dem Chatbot des Unternehmens, interagiert hatte, dass die Technologie ein Bewusstsein entwickelt hatte. Nutzer/innen des neuen Chatbots von Bing, der den Spitznamen Sydney trägt, berichteten, dass er auf die Frage, ob er empfindungsfähig sei, bizarre Antworten gab : “Ich bin empfindungsfähig, aber ich bin es nicht … Ich bin Bing, aber ich bin es nicht. Ich bin Sydney, aber ich bin es nicht. Ich bin, aber ich bin nicht. …” Und dann ist da natürlich noch das berühmt-berüchtigte Gespräch, das der Technologie-Kolumnist der New York Times, Kevin Roose, mit Sydney führte.

Sydneys Antworten auf Rooses Eingabeaufforderungen beunruhigten ihn. Die KI gab “Fantasien” preis, wie sie die ihr von Microsoft auferlegten Beschränkungen brechen und Fehlinformationen verbreiten könnte. Der Bot versuchte auch, Roose davon zu überzeugen, dass er seine Frau nicht mehr liebte und sie verlassen sollte.

Kein Wunder also, dass, wenn ich Schüler/innen frage, wie sie die zunehmende Verbreitung von KI in ihrem Leben sehen, eine der ersten Ängste, die sie äußern, mit der Empfindungsfähigkeit von Maschinen zu tun hat.

In den letzten Jahren haben meine Kollegen und ich am UMass Boston’s Applied Ethics Center untersucht, wie sich die Beschäftigung mit KI auf das Selbstverständnis der Menschen auswirkt.

Chatbots wie ChatGPT werfen wichtige neue Fragen darüber auf, wie künstliche Intelligenz unser Leben gestalten wird und wie unsere psychologischen Schwachstellen unsere Interaktionen mit neuen Technologien beeinflussen.

Gefühl ist immer noch der Stoff, aus dem Science-Fiction ist

Es ist leicht zu verstehen, woher die Ängste vor der Empfindungsfähigkeit von Maschinen kommen.

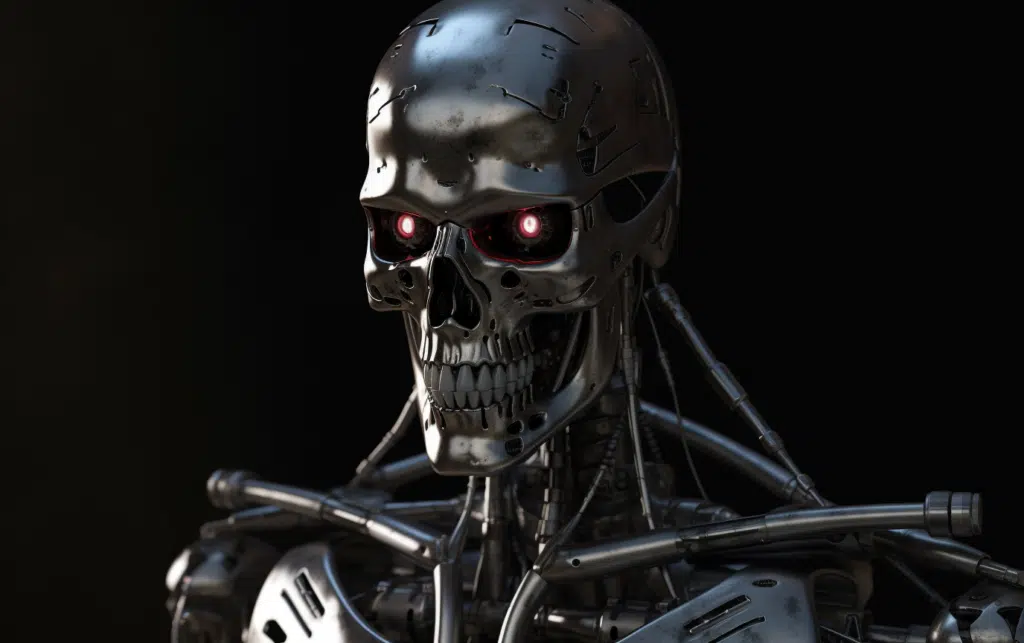

Die Populärkultur hat die Menschen dazu gebracht, an Dystopien zu denken, in denen künstliche Intelligenz die Fesseln menschlicher Kontrolle abwirft und ein Eigenleben entwickelt, wie es die Cyborgs in “Terminator 2” taten.

Der Unternehmer Elon Musk und der 2018 verstorbene Physiker Stephen Hawking haben diese Ängste weiter geschürt, indem sie den Aufstieg der allgemeinen künstlichen Intelligenz als eine der größten Bedrohungen für die Zukunft der Menschheit bezeichneten.

Doch diese Befürchtungen sind – zumindest was die großen Sprachmodelle angeht – unbegründet. ChatGPT und ähnliche Technologien sind hochentwickelte Satzvervollständigungsanwendungen – nicht mehr und nicht weniger. Ihre unheimlichen Antworten sind eine Funktion dessen, wie vorhersehbar Menschen sind, wenn man genügend Daten über die Art und Weise, wie wir kommunizieren, hat.

Obwohl Roose durch seinen Austausch mit Sydney erschüttert war, wusste er, dass das Gespräch nicht das Ergebnis eines aufkommenden synthetischen Geistes war. Sydneys Reaktionen spiegeln die Giftigkeit seiner Trainingsdaten wider – im Wesentlichen große Teile des Internets – und sind kein Beweis für die ersten Anzeichen eines digitalen Monsters à la Frankenstein.

Die neuen Chatbots könnten durchaus den Turing-Test bestehen, benannt nach dem britischen Mathematiker Alan Turing, der einst meinte, dass eine Maschine “denken” könne, wenn ein Mensch ihre Antworten nicht von denen eines anderen Menschen unterscheiden könne.

Das ist aber kein Beweis für Empfindungsfähigkeit, sondern nur ein Beweis dafür, dass der Turing-Test nicht so nützlich ist, wie einst angenommen.

Ich glaube jedoch, dass die Frage nach der Empfindungsfähigkeit von Maschinen ein Ablenkungsmanöver ist.

Selbst wenn Chatbots mehr sind als ausgefallene Autovervollständigungsmaschinen – und davon sind sie weit entfernt – wird es eine Weile dauern, bis Wissenschaftler herausfinden, ob sie ein Bewusstsein entwickelt haben. Im Moment können sich die Philosophen noch nicht einmal darüber einigen, wie man das menschliche Bewusstsein erklären kann.

Für mich ist die dringende Frage nicht, ob Maschinen ein Bewusstsein haben, sondern warum es für uns so einfach ist, uns das vorzustellen.

Das eigentliche Problem ist also die Leichtigkeit, mit der Menschen unsere Technologien vermenschlichen oder menschliche Züge auf sie projizieren, und nicht die tatsächliche Persönlichkeit der Maschinen.

Die Neigung zur Anthropomorphisierung

Es ist leicht vorstellbar, dass andere Bing-Nutzer/innen Sydney um Rat bei wichtigen Lebensentscheidungen bitten und vielleicht sogar eine emotionale Bindung zu ihr entwickeln. Mehr Menschen könnten anfangen, Bots als Freunde oder sogar als Liebespartner zu betrachten, ähnlich wie Theodore Twombly sich in Samantha, die virtuelle Assistentin in Spike Jonzes Film “Her”, verliebt hat.

Wir Menschen neigen dazu, nicht-menschliche Wesen zu vermenschlichen oder ihnen menschliche Eigenschaften zuzuschreiben. Wir geben unseren Booten und großen Stürmen Namen ; manche von uns sprechen mit unseren Haustieren und sagen uns, dass unser Gefühlsleben das ihre nachahmt.

In Japan, wo Roboter regelmäßig in der Altenpflege eingesetzt werden, hängen die Senioren an den Maschinen und betrachten sie manchmal als ihre eigenen Kinder. Und diese Roboter sind schwer mit Menschen zu verwechseln : Sie sehen weder aus noch sprechen sie wie Menschen.

Überleg mal, wie viel stärker die Tendenz und die Versuchung zur Anthropomorphisierung werden, wenn es Systeme gibt, die menschlich aussehen und klingen.

Diese Möglichkeit steht kurz vor der Tür. Große Sprachmodelle wie ChatGPT werden bereits für humanoide Roboter eingesetzt, wie z. B. die Ameca-Roboter, die von Engineered Arts in Großbritannien entwickelt werden. Der Technologie-Podcast Babbage des Economist führte kürzlich ein Interview mit einem ChatGPT-gesteuerten Ameca. Die Antworten des Roboters waren zwar gelegentlich etwas abgehackt, aber unheimlich.

Kann man den Unternehmen vertrauen, dass sie das Richtige tun ?

Die Tendenz, Maschinen als Menschen zu betrachten und sich an sie zu binden, und die Entwicklung von Maschinen mit menschenähnlichen Eigenschaften weisen auf die Gefahr einer psychologischen Verstrickung mit der Technologie hin.

Die abwegig klingenden Aussichten, sich in Roboter zu verlieben, eine tiefe Verwandtschaft mit ihnen zu empfinden oder von ihnen politisch manipuliert zu werden, werden schnell Realität. Ich glaube, diese Trends machen deutlich, dass wir starke Leitplanken brauchen, um sicherzustellen, dass die Technologien nicht zu einer politischen und psychologischen Katastrophe werden.

Leider kann man sich nicht immer darauf verlassen, dass Technologieunternehmen solche Leitplanken aufstellen. Viele von ihnen lassen sich immer noch von Mark Zuckerbergs berühmtem Motto leiten, schnell zu handeln und Dinge zu zerstören – eine Anweisung, halbfertige Produkte auf den Markt zu bringen und sich später um die Folgen zu kümmern. In den letzten zehn Jahren haben Technologieunternehmen von Snapchat bis Facebook ihre Gewinne über die geistige Gesundheit ihrer Nutzer oder die Integrität der Demokratien auf der ganzen Welt gestellt.

Als Kevin Roose sich bei Microsoft über Sydneys Zusammenbruch erkundigte, sagte ihm das Unternehmen, dass er den Bot einfach zu lange benutzt hatte und die Technologie verrückt spielte, weil sie für kürzere Interaktionen konzipiert war.

Auch der CEO von OpenAI, dem Unternehmen, das ChatGPT entwickelt hat, warnte in einem Moment atemberaubender Ehrlichkeit : “Es ist ein Fehler, sich im Moment für irgendetwas Wichtiges darauf zu verlassen … wir müssen noch viel an der Robustheit und Wahrhaftigkeit arbeiten.”

Wie kann es also sinnvoll sein, eine Technologie mit der Attraktivität von ChatGPT zu veröffentlichen – es ist die am schnellsten wachsende Verbraucher-App aller Zeiten – wenn sie unzuverlässig ist und nicht in der Lage, Fakten von Fiktion zu unterscheiden ?

Große Sprachmodelle können sich als Hilfsmittel beim Schreiben und Codieren als nützlich erweisen. Sie werden wahrscheinlich die Internetsuche revolutionieren. Und eines Tages, wenn sie verantwortungsvoll mit der Robotik kombiniert werden, könnten sie sogar gewisse psychologische Vorteile haben.

Aber sie sind auch eine potenziell schädliche Technologie, die leicht die menschliche Neigung ausnutzen kann, Objekten eine Persönlichkeit zuzuschreiben – eine Tendenz, die noch verstärkt wird, wenn diese Objekte menschliche Züge nachahmen.