Microsofts gefälschter Marktplatz enthüllt die größten Schwächen von KI-Agenten

06/11/2025

Apple könnte Google eine Milliarde Dollar pro Jahr zahlen, um Siri zu verbessern

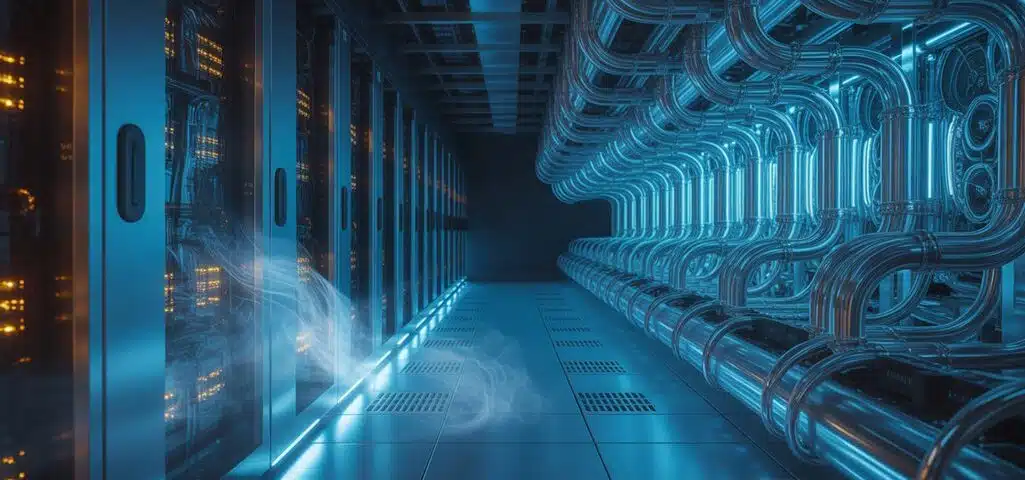

07/11/2025KI-Server erzeugen jetzt genug Wärme, um kleine Städte zu versorgen, was genau die Art von Problem ist, die niemand kommen sah, als Rechenzentren nur Reihen von summenden Kästen waren. Metallkühltechnologie verspricht, diesen thermischen Albtraum zu lösen, indem Kupfer direkt gegen Prozessoren platziert wird und dabei die zunehmend unzureichenden Luftkühlsysteme umgeht, die mit den heutigen 200-Kilowatt-Racks kämpfen. Die Frage ist nicht, ob traditionelle Kühlmethoden versagen, sondern ob diese metallische Intervention tatsächlich die noch anspruchsvolleren Arbeitslasten von morgen bewältigen kann.

Die Hitzekrise : Wie KI-Server thermische Grenzen überschreiten

Während Rechenzentren einst mit den vorhersagbaren thermischen Lasten herkömmlicher Server vor sich hin brummten, haben KI-Arbeitslasten die Hitze im Wesentlichen auf Niveaus gedreht, die ein Stahlwerk nervös machen würden, wobei die Rack-Leistungsdichten nun routinemäßig 100 Kilowatt überschreiten und einige Installationen in Richtung des 50–100 kW-Bereichs drängen, der noch vor wenigen Jahren als theoretisch galt. NVIDIAs neueste Blackwell B200 GPU allein verbraucht 1.200 Watt, während ihr GB200-System 2.700 Watt erreicht, was bedeutet, dass Wärmemanagement weniger um sanfte Kühlung geht und mehr darum, Server-Zusammenbrüche zu verhindern. Traditionelle Luftkühlung, einst ausreichend für Chips, die 150 Watt erzeugten, steht nun vor der unmöglichen Aufgabe, über 700 Watt von einzelnen Komponenten abzuführen, was Servereffizienz zu einem fernen Traum macht, wenn Ihr Kühlsystem 40% der gesamten Anlagenleistung verbraucht. Fortschrittliche Lösungen wie Immersionskühlung entstehen als Spielveränderer, wobei die Technologie den Energieverbrauch um bis zu 50% im Vergleich zu herkömmlichen Methoden reduzieren kann.

Metall-Kühlungstechnologie : Direkter Wärmetransfer an der Quelle

Die Eleganz der Metallkühltechnologie liegt in ihrer grundlegenden Einfachheit, die darin besteht, hochleitfähige Metalle wie Kupfer und Aluminium direkt gegen die Komponenten zu platzieren, die die meiste Wärme erzeugen, wodurch im Wesentlichen der Mittelsmann ausgeschaltet wird, auf den die Luftkühlung so stark angewiesen ist. Diese Kühllösungen funktionieren durch direkte Wärmeleitung, bei der Kühlplatten physischen Kontakt mit CPUs und GPUs herstellen und einen direkten Weg für die Wärme schaffen, zu entweichen, ohne den üblichen Tanz der bewegten Luft in der Hoffnung, dass etwas Gutes passiert. Kupfer-Kühlplatten erreichen Wärmeleitfähigkeitsraten von bis zu 400 W/m·K, während Dampfkammern und Mikrokanal-Wärmetauscher den Oberflächenkontakt maximieren. Im Gegensatz zu herkömmlichen Kühlsystemen, die auf flüssige Kältemittel angewiesen sind, übertragen diese Festkörper-Metalllösungen thermische Energie durch feste Leiter und eliminieren potenzielle Leckstellen und reduzieren die mechanische Komplexität. Das Ergebnis sind Kühlsysteme, die Wärmelasten von über 200 kW pro Rack bewältigen können, obwohl die anfänglichen Kosten die traditionelle Luftkühlung erfrischend erschwinglich aussehen lassen.

Branchenführer setzen auf fortschrittliche Flüssigkühlungslösungen

Große Hyperscaler haben die experimentelle Phase mit Flüssigkeitskühlung hinter sich gelassen, und Unternehmen wie Meta, Microsoft und Nvidia setzen sich nun öffentlich für diese Systeme als wesentliche Infrastruktur für ihre KI-Operationen ein, was einen bedeutenden Wandel von dem vorsichtigen Antesten darstellt, das die Branche noch vor wenigen Jahren charakterisierte. Diese Branchenakzeptanz hat eine Lieferknappheit geschaffen, die amüsant wäre, wenn sie nicht so vorhersehbar gewesen wäre—die Nachfrage nach Kühlmittelverteilungseinheiten übersteigt das Angebot nun um das 4–5‑fache.

| Herausforderung | Branchenreaktion |

|---|---|

| CDU-Knappheit | LiquidStack verdoppelte die US-Produktionskapazität |

| Lieferzeiten über 12 Monate | Vertiv und CoolIT erweitern ihre Betriebe |

| Designkomplexität | Standardisierungsbemühungen bei verschiedenen Anbietern |

Die Ironie liegt natürlich darin, dass plötzlich alle dieselbe Kühltechnologie benötigen, die sie einst für unnötig hielten. Marktanalysten prognostizieren, dass Flüssigkeitskühlung innerhalb des nächsten Jahrzehnts zur Standardinfrastruktur für hochdichte KI-Anlagen wird, da die rechnerischen Anforderungen weiter steigen.

Umweltvorteile und Energieeffizienzgewinne

Jenseits der unmittelbaren Leistungssteigerungen, die Schlagzeilen machen, liefern Flüssigkühlungstechnologien Umweltvorteile, die Rechenzentrumsbetreiber sich nicht mehr leisten können zu ignorieren, insbesondere da KI-Arbeitslasten den Energieverbrauch auf Niveaus treiben, die selbst Kryptowährungs-Miner erröten lassen würden. Metallbasierte Kühlsysteme, einschließlich kalter unterirdischer thermischer Energiespeicherung, senken den Energiebedarf um bis zu 30%, während sie den Wasserverbrauch reduzieren, der andernfalls jährlich Milliarden von Litern erreicht. Diese Innovationen ermöglichen nachhaltiges Wachstum, indem sie Kühlkapazität saisonal speichern, Spitzenlasten im Stromnetz reduzieren, wenn alle anderen gleichzeitig ihre Klimaanlagen aufdrehen, und eine bessere Integration von erneuerbaren Energiequellen unterstützen, die tatsächlich mit Bedarfszyklen kooperieren wollen. Das National Renewable Energy Laboratory führt bahnbrechende Forschung zu Cold UTES-Technologie durch, die geothermische Stromerzeugung mit fortschrittlichen Kühllösungen kombiniert, um widerstandsfähigere Rechenzentrumsinfrastruktur zu schaffen.

- Direkte Flüssigkühlung eliminiert den ineffizienten Zwischenhändler der Luftzirkulation und liefert Kühlmittel präzise dorthin, wo Wärme tatsächlich entsteht

- Reduzierte Wasserabhängigkeit schützt lokale Gemeinden vor Ressourcenkonkurrenz mit energiehungrigen Serverfarmen

- Geringerer Strombedarf insgesamt schafft Spielraum für Netzinfrastruktur ohne massive Versorgungsupgrades zu erfordern

Skalierung der Metallkühlung für die 600-kW-Rechenzentren von morgen

Während Umweltvorteile eine überzeugende langfristige Rechtfertigung für die Einführung von Flüssigkeitskühlung bieten, steht die unmittelbare Realität, mit der Rechenzentrumsoperatoren konfrontiert sind, vor der Herausforderung, KI-Arbeitslasten zu bewältigen, die über traditionelle Wärmemanagement-Annahmen spotten, wobei einige prognostizierte Implementierungen 600 kW pro Rack anstreben—etwa achtmal mehr als Luftkühlung bewältigen kann, bevor sie aufgibt. Die technische Herausforderung besteht nicht nur darin, mehr Wärme abzutransportieren, sondern auch darin, periphere Komponenten wie RAM und Netzwerk-Chips zu kühlen, die plötzlich wichtig werden, wenn alles nuklear-heiß läuft. Diese Anlagen müssen 100% Kapazität kontinuierlich aufrechterhalten und verlangen beispiellose Zuverlässigkeit von der Kühlinfrastruktur, die niemals eine Pause bekommt. Kundenspezifische Designs werden obligatorisch statt optional, da Standard-Lösungen für diese Leistungsdichten schlichtweg nicht existieren. Die Minimierung des Wärmewiderstands zwischen Chips und Kühlplatten erfordert Materialentwicklung, die traditionelles Serverdesign im Vergleich dazu antiquiert erscheinen lässt.

Quellenangabe

- https://www.coresite.com/blog/liquid-cooling-steps-up-for-high-density-racks-and-ai-workloads

- https://www.techbuzz.ai/articles/startup-s-metal-stacks-tackle-ai-s-600kw-cooling-crisis

- https://blogs.nvidia.com/blog/blackwell-platform-water-efficiency-liquid-cooling-data-centers-ai-factories/

- https://www.boydcorp.com/applications/ai-cooling.html

- https://news.microsoft.com/source/features/innovation/microfluidics-liquid-cooling-ai-chips/

- https://flexpowermodules.com/the-basics-of-liquid-cooling-in-ai-data-centers

- https://blog.marketresearch.com/why-data-center-cooling-is-the-next-big-tech-battleground

- https://airsysnorthamerica.com/current-cooling-limitations-slowing-ai-data-center-growth/

- https://www.solidigm.com/products/technology/data-center-ai-thermal-considerations.html

- https://airsysnorthamerica.com/managing-ai-heat-with-ai-cooling-in-data-centers/