Google führt Scholar Labs ein

23/11/2025

Die dunkle Spiegelung von Frankenstein und die moderne Technologie

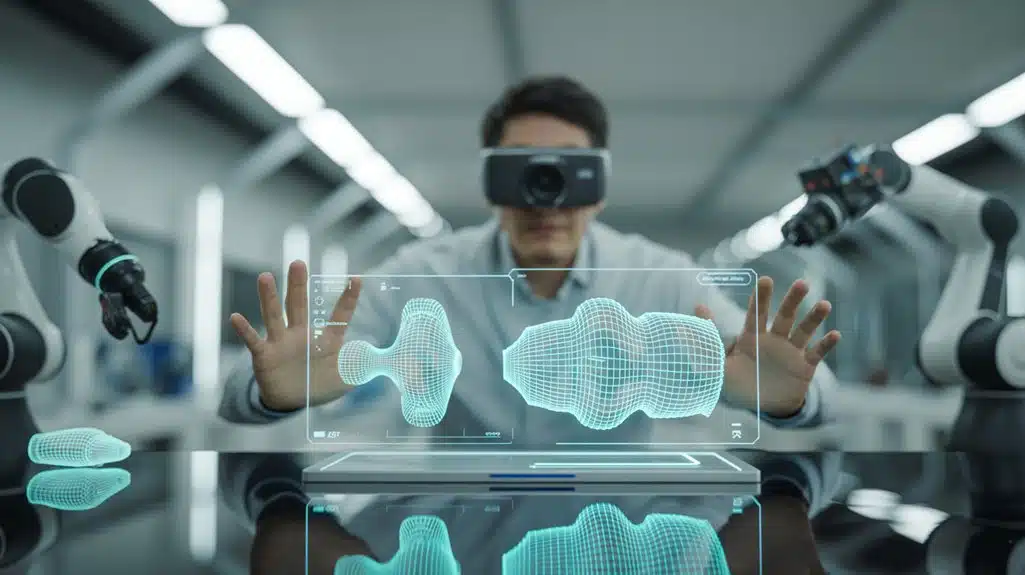

24/11/2025Metas neueste Errungenschaft ermöglicht es Einzelpersonen, gewöhnliche Fotos fast sofort in 3D-Modelle zu verwandeln. Die Technologie, genannt SAM 3D, funktioniert wie Magie—zeige auf ein beliebiges Objekt oder eine Figur in einem Bild, und es wird zu etwas, das du drehen und verändern kannst. Was dies besonders aufregend macht, ist wie der Technologie-Riese zwei separate Systeme entwickelt hat, die zusammenarbeiten und jeweils verschiedene Herausforderungen bewältigen. Die Marke hat gerade alles für jeden zugänglich gemacht, was Türen für Kreative überall öffnet.

Zwei spezialisierte Modelle für Objekte und menschliche Körper

Metas SAM 3D kommt mit einer praktischen Aufteilung : ein Modell bearbeitet alltägliche Objekte, während sich das andere auf menschliche Körper konzentriert. Dieser Ansatz gibt den Nutzern die Freiheit, zu rekonstruieren, was sie benötigen. Das Objektmodell verwandelt jeden maskierten Gegenstand in einem Foto in ein vollständiges 3D-Netz mit Textur und Position. Es funktioniert bei Stühlen, Spielzeug oder Werkzeugen—allem, was man fotografieren kann. Währenddessen spezialisiert sich das Körpermodell auf menschliche Darstellung und erstellt vollständige Netze aus einzelnen Bildern. Es erfasst Posen genau, selbst wenn Kleidung Teile einer Person verdeckt oder sie in ungewöhnlichen Positionen stehen. Beide Modelle unterstützen Objektinteraktion durch bearbeitbare Ausgaben, die man bewegen und anpassen kann. Das System produziert verwendbare Netze mit Texturen, die saubere Kanten und Oberflächendetails beibehalten. Zusammen bilden sie ein flexibles System, das reale Szenen bewältigt, in denen Personen und Gegenstände nebeneinander erscheinen.

Transformer-Architektur und Millionen-Maßstab-Trainings-Pipeline

Hinter der funktionalen Aufspaltung von SAM 3Ds dualen Modellen liegt eine mächtige technische Grundlage, die auf modernen Konvertierungsnetzwerken basiert. Meta integrierte Transformer-Effizienz in jede Schicht und ermöglichte so die schnelle Verarbeitung von Bildern zu detaillierten 3D-Netzen. Das System verwendet intelligente Kodierung, die Bilder liest und Formen, Posen und Texturen in Stufen vorhersagt.

Was diesen Fortschritt möglich macht, ist skalierbares Training auf einem beispiellosen Niveau. Meta annotierte fast eine Million verschiedene Bilder und erstellte über drei Millionen 3D-Netzmodelle zum Trainieren des Systems. Menschliche Prüfer arbeiteten zusammen mit automatisierten Werkzeugen und verfeinerten die Qualität durch Rückkopplungsschleifen. Diese Kombination stellte sicher, dass die Modelle lernten, schwierige reale Szenarien zu bewältigen—unübersichtliche Hintergründe, seltsame Winkel, teilweise verdeckte Objekte.

Der progressive Trainingsansatz baut Komplexität schrittweise auf, beginnt einfach und fügt mit der Zeit Details hinzu. Das System liefert Rekonstruktionen in Sekunden unter Verwendung von Optimierungen und macht es für Anwendungen geeignet, die nahezu sofortige Ergebnisse erfordern.

Von einem einzelnen RGB-Bild zu editierbarem 3D-Netz

Die Magie passiert, wenn jemand ein Foto mit seinem Handy macht. SAM 3D verwandelt dieses gewöhnliche Bild in etwas, das man berühren, drehen und im digitalen Raum verändern kann. Das System beginnt mit Bildsegmentierung und identifiziert Objekte oder Personen in Ihrer Aufnahme. Jedes segmentierte Stück wird zu seiner eigenen 3D-Kreation.

Keine ausgefallene Ausrüstung nötig—nur ein normales Foto. Die Technologie behandelt unordentliche Hintergründe und versteckte Teile automatisch. Sie erhalten tatsächliche Mesh-Dateien, die für Mesh-Bearbeitung in Ihren bevorzugten Tools bereit sind. Wollen Sie Farben ändern ? Merkmale umformen ? Ihre Kreation in einem virtuellen Raum platzieren ? Alles möglich.

Diese Freiheit erstreckt sich auf jeden, nicht nur auf Spezialisten. Laden Sie Ihr Bild hoch, und Momente später laden Sie ein funktionierendes 3D-Modell herunter. Perfekt für den Aufbau von AR-Erlebnissen oder zur Produktvisualisierung ohne teure Scan-Ausrüstung. Das System produziert texturierte Meshes, die sowohl Geometrie als auch Aussehen aus einem einzigen RGB-Bild erfassen.

Neuer Benchmark-Datensatz in Zusammenarbeit mit Künstlern erstellt

Der Aufbau von etwas Innovativem erfordert mehr als cleveren Code. Meta arbeitete mit professionellen Künstlern zusammen, um SA-3DAO zu schaffen, einen bahnbrechenden Evaluierungs-Benchmark. Diese Beteiligung von Künstlern gewährleistet Dataset-Realismus, der unsere physische Welt wirklich widerspiegelt. Die Sammlung umfasst fast 1 Million Bilder, die alltägliche Gegenstände wie Stühle, Werkzeuge und Haushaltsgeräte zeigen.

| Dataset-Merkmal | Umfang | Zweck |

|---|---|---|

| Annotierte Bilder | ~1 Million | Realwelt-Training |

| Generierte Meshes | 3,14 Millionen | Modellverifikation |

| Expertenprüfung | Schwierigste Fälle | Qualitätssicherung |

Künstler halfen dabei, Formen, Texturen und Layouts zu verifizieren. Sie bewerteten mehrere Mesh-Optionen und tackled herausfordernde Beispiele. Dieser menschenzentrierte Ansatz geht über inszenierte Fotos und synthetische Assets hinaus. Das Ergebnis ist eine robuste Grundlage, die die 3D-Rekonstruktionsforschung in Richtung echten physischen Verständnisses vorantreibt. SAM 3D Objects erreichte eine 5:1 Gewinnrate im Vergleich zu konkurrierenden Modellen in Wirksamkeitstests.

Öffentliche Veröffentlichung ermöglicht AR/VR- und Robotikentwicklung

Meta hat die Tür weit für SAM 3D geöffnet und gewährt Entwicklern und Forschern vollen Zugang zu Modell-Checkpoints und Inference-Code. Jeder kann nun AR-Anwendungen erstellen oder Robotik-Innovation mit diesem mächtigen Werkzeug vorantreiben. Ein webbasierter Spielplatz ermöglicht es Nutzern, Fotos hochzuladen und zu beobachten, wie sie sich sofort in 3D-Modelle verwandeln. APIs machen es einfach, diese Technologie in bestehende Projekte zu integrieren, von Virtual-Reality-Erfahrungen bis hin zu Roboter-Vision-Systemen. Die kommerzielle Lizenz umfasst sogar Metas parametrisches menschliches Modell und beseitigt rechtliche Hürden für Unternehmen. Meta testet SAM 3D auch für eine In Raum anzeigen-Funktion auf Facebook Marketplace, um Käufern zu helfen, Möbel und Dekoration in ihren eigenen Räumen vorab zu betrachten.

Hauptmerkmale der öffentlichen Veröffentlichung :

- Open-Source-Code und Modellgewichte kostenlos verfügbar

- Web-Spielplatz für sofortiges Testen ohne technische Einrichtung

- Gebrauchsfertige APIs für nahtlose Integration von Drittanbietern

- Kommerzielle Lizenzierung für Industrieanwendungen enthalten

- SA-3DAO-Benchmark-Datensatz zur Leistungsbewertung

Diese Veröffentlichung legt ausgeklügelte 3D-Rekonstruktion in jedermanns Hände und demokratisiert den Zugang zu Werkzeugen, die einst großen Forschungslaboren vorbehalten waren.

Quellenangabe

- https://skywork.ai/blog/ai-image/sam-3d-ultimate-guide/

- https://www.socialsamosa.com/news‑2/meta-3d-modeling-tools-marketplace-10791337

- https://ai.meta.com/sam3d/

- https://designzig.com/metas-foundational-sam-3d-objects-model-transforms-2d-photos-into-complete-3d-models/amp/

- https://www.youtube.com/watch?v=B7PZuM55ayc

- https://designzig.com/metas-foundational-sam-3d-objects-model-transforms-2d-photos-into-complete-3d-models/

- https://github.com/facebookresearch/sam-3d-objects

- https://skywork.ai/skypage/en/ai-revolution-2d-3d-reconstruction/1991381904639614976

- https://about.fb.com/news/2025/11/new-sam-models-detect-objects-create-3d-reconstructions/

- https://blockchain.news/ainews/meta-unveils-sam-3d-state-of-the-art-ai-model-for-3d-object-and-human-reconstruction-from-2d-images