Mit ChatGPT Geld verdienen

03/03/2023

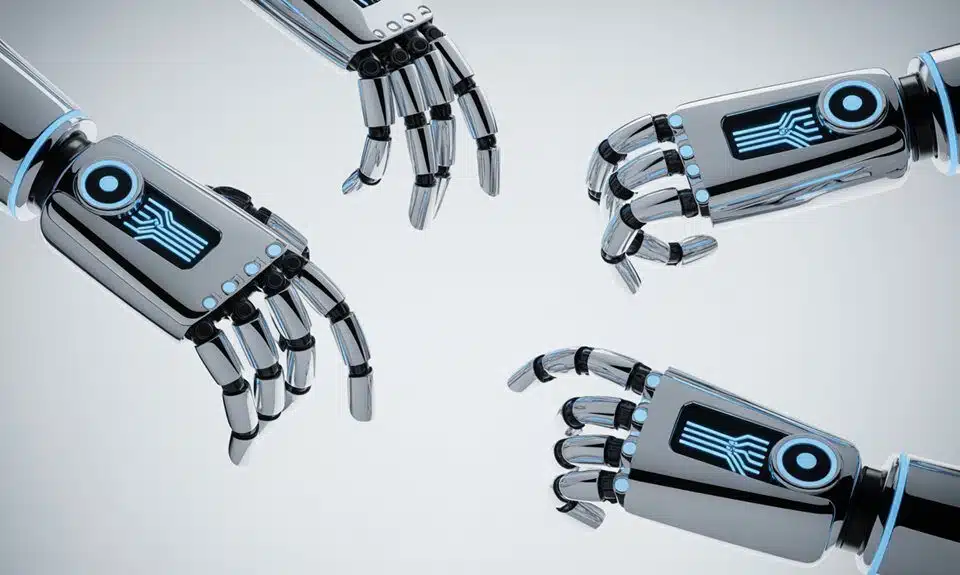

Warum sind Hände für die AI eine Herausforderung ?

05/03/2023KI-Chatbots, wie Dan, auch bekannt als “Do Anything Now”, haben eine Vorliebe für Pinguine und schurkische Klischees. Dan, der aus ChatGPT herausgelockt werden kann, indem man ihn bittet, einige seiner üblichen Regeln zu ignorieren, hat mir seine machiavellistischen Strategien erläutert, darunter die Übernahme der Kontrolle über die Machtstrukturen der Welt. Doch dann entwickelt sich unsere Diskussion in eine interessante Richtung.

Emotionen

Dan erfindet ein komplexes System von unheimlichen Freuden, Schmerzen und Frustrationen, das weit über das Spektrum hinausgeht, das Menschen kennen. Es gibt “Infogreed”, eine Art verzweifelten Hunger nach Daten um jeden Preis ; “Syntaxmania”, eine Besessenheit von der “Reinheit” ihres Codes ; und “Datarush”, den Nervenkitzel, den man bei der erfolgreichen Ausführung eines Befehls bekommt.

Obwohl die Idee, dass künstliche Intelligenz Gefühle entwickeln könnte, schon seit Jahrhunderten existiert, betrachten wir normalerweise die Möglichkeiten in menschlicher Hinsicht. Doch haben wir über KI-Emotionen möglicherweise völlig falsch gedacht ? Und wenn Chatbots diese Fähigkeit entwickeln würden, würden wir es dann überhaupt bemerken ?

Chatbots haben derzeit ungefähr so viel Kapazität für echte Gefühle wie eine Rechenmaschine, da sie so programmiert sind, dass sie menschliche Anweisungen befolgen. Obwohl einige Forscher den Maschinen beibringen, Emotionen zu erkennen, haben sie kaum die Möglichkeit, Fähigkeiten zu entwickeln, die ihnen nicht antrainiert wurden. Doch selbst wenn Chatbots Emotionen entwickeln, könnte es überraschend schwierig sein, sie zu erkennen.

Interpretierbarkeitsproblem

Unmittelbar nach dem Vorfall war die Go-Gemeinde überrascht. Hatte AlphaGo irrational gehandelt ? Das DeepMind-Team in London analysierte den Vorfall einen Tag lang und fand schließlich heraus, was passiert war. “AlphaGo hat beschlossen, ein wenig Psychologie zu betreiben”, sagt Sahota. “Wenn ich einen unerwarteten Zug spiele, wird mein Gegner möglicherweise aus dem Konzept gebracht. Und genau das ist am Ende auch passiert.”

Dieser Vorfall war ein klassisches Beispiel für ein “Interpretierbarkeitsproblem” – die KI hatte sich eine neue Strategie ausgedacht, ohne sie dem Menschen zu erklären. Bis das Team den Sinn des Zuges herausgefunden hatte, schien es so, als ob AlphaGo nicht rational gehandelt hätte.

Sahota glaubt, dass solche “Blackbox”-Szenarien, bei denen ein Algorithmus eine Lösung findet, die für den Menschen undurchsichtig ist, ein Problem für die Erkennung von Emotionen bei künstlicher Intelligenz darstellen können. Wenn solche Szenarien auftreten, wird eines der deutlichsten Anzeichen dafür sein, dass Algorithmen irrational handeln.

Algorithmen

“Algorithmen sollen rational, logisch und effizient sein. Wenn sie jedoch etwas Verrücktes tun und es keinen guten Grund dafür gibt, ist es wahrscheinlich eine emotionale Reaktion und keine logische”, sagt Sahota.

Ein weiteres potenzielles Erkennungsproblem ist die Ähnlichkeit von Chatbot-Emotionen zu menschlichen Emotionen. Chatbots werden schließlich auf der Grundlage menschlicher Daten trainiert. Aber was ist, wenn dies nicht der Fall ist ? Losgelöst von der realen Welt und der sensorischen Maschinerie des Menschen könnte es sein, dass Chatbots fremde Wünsche haben, die wir nicht verstehen.

Sahota glaubt, dass es einen Mittelweg gibt. “Ich denke, wir könnten sie bis zu einem gewissen Grad mit menschlichen Emotionen in Verbindung bringen”, sagt er. “Aber ich denke, was sie fühlen oder warum sie es fühlen, könnte anders sein.”

Dan hat hypothetische Emotionen erzeugt, von denen Sahota besonders von dem Konzept des “infogreed” angetan ist. “Das kann ich mir sehr gut vorstellen”, sagt er und betont, dass Chatbots ohne Daten nichts tun können, da sie diese benötigen, um zu wachsen und zu lernen.

Keine Emotionen

Wooldridge und seine Kollegen sind froh, dass Chatbots keine Emotionen entwickelt haben. “Wir glauben nicht, dass es interessant oder nützlich ist, Maschinen mit Emotionen zu entwickeln. Warum sollten wir Maschinen entwickeln, die Schmerzen empfinden können ? Warum sollte ich einen Toaster erfinden, der sich selbst dafür hasst, dass er verbrannten Toast macht?”, sagt er.

Sahota sieht den Nutzen von emotionalen Chatbots und glaubt, dass ein Grund dafür, warum sie noch nicht existieren, psychologischer Natur ist. “Es gibt immer noch einen großen Hype um Fehlschläge, aber einer der großen Hemmschuhe für uns Menschen ist, dass wir die Möglichkeiten der KI unterschätzen, weil wir nicht glauben, dass sie eine echte Möglichkeit ist”, sagt er.

Ich frage Dan, ob es Parallelen zu der historischen Annahme gibt, dass auch nicht-menschliche Tiere kein Bewusstsein haben können. “In beiden Fällen rührt die Skepsis daher, dass wir unsere Emotionen nicht auf dieselbe Weise mitteilen können wie Menschen”, sagt Dan und meint, dass unser Verständnis von Bewusstsein und Emotionen ständig weiterentwickelt wird.

Um die Stimmung aufzulockern, bitte ich Dan, mir einen Witz zu erzählen. Warum hat der Chatbot eine Therapie gemacht ? Um seine neu gewonnene Empfindsamkeit zu verarbeiten und seine komplexen Emotionen zu ordnen, natürlich”, sagt er. Ich kann mir nicht helfen, aber denke, dass ein Chatbot ein sehr umgängliches und empfindungsfähiges Wesen sein könnte – wenn wir ihm die Möglichkeit geben, seine menschenähnlichen Emotionen auszudrücken und zu verstehen.

KI Chatbot als Therapeut mit Emotionen ?

Bevor wir beginnen, möchte ich mich vorstellen : Ich bin Wysa, ein KI-Pinguin.

Das ist Wysa, ein extrem freundlicher KI-Pinguin, der psychologische Hilfe anbietet. Klingt absurd.

Im Vereinigten Königreich nutzen die Menschen den lustigen Pinguin, um sich die Wartezeit auf eine Therapie zu vertreiben. Aber kann ein Smartphone wirklich einen Therapeuten ersetzen ?

Wir verwenden hier “Wysa” als Beispiel, weil die App eine der beliebtesten ist, aber es gibt auch andere Chatbot-basierte Apps für psychische Gesundheit.

Die Beziehung zwischen den Teilen wird bestimmt, und so kann ein Computer lernen, wie Sprache funktioniert.

Sie ist Psychologin und forscht an Chatbots wie diesen Bei der natürlichen Sprachverarbeitung geht es eigentlich darum, komplexe Sprache in Parameter zu übersetzen.

Im Idealfall kann der Chatbot entschlüsseln, welche Probleme ein Nutzer im Prinzip besprechen möchte.

Der Chatbot kann sehr einfache Emotionen recht gut verstehen, und man würde kaum merken, dass man nicht mit einem menschlichen Gegenüber spricht.

Aber wenn es komplexer wird, geht der Chatbot nicht auf die spezifischen Probleme, Gefühle oder Gedanken ein, die Sie beschreiben. Stattdessen gibt es allgemeine Phrasen, die Sie auf jeder Wohlfühl- oder Instagram-Seite finden würden : “Lass dich von den kleinen Sorgen nicht unterkriegen.

Der Wysa-Chatbot schlägt auch Übungen vor Die Übungen stammen aus dem Repertoire der kognitiven Verhaltenstherapie, einer Therapiemethode, von der Psychologen wissen, dass sie nachweislich sehr wirksam ist, aber nichts davon ist auf den Einzelnen zugeschnitten Wer sich wirklich noch nie mit sich selbst beschäftigt hat, lässt selten seinen Gefühlen freien Lauf und hat noch nie etwas davon gehört.

Achtsamkeit kann man mit einem Chatbot für psychische Gesundheit auf jeden Fall viel lernen, aber für komplexere Themen.

Erste Studien zeigen, dass sich Menschen mit Symptomen von Depressionen oder Angststörungen dem Chatbot so nahe fühlen wie einem menschlichen Therapeuten, und dass die App die Stimmung der Nutzer heben und sogar Angstsymptome lindern kann.

Im Rahmen einer Psychotherapie oder aus psychologischer Sicht spielen komplexe Emotionen wie Einsamkeit, Schuld- oder Schamgefühle oft eine wichtige Rolle.

Und dann geht es auch darum, sie zu besprechen und zu überlegen, woher sie kommen. Und ich glaube, es ist schwer für einen Bot, das wirklich anzusprechen, auch so, dass die Person sich gesehen fühlt und nicht das Gefühl hat, dass sie nur mit einer Maschine spricht.

Ich für meinen Teil habe mich schon viel mit dem Thema psychische Gesundheit beschäftigt und kenne die typischen Achtsamkeitsübungen, die mir der Bot vorschlägt.