Wie Du das ChatGPT Wasserzeichen entfernst

17/04/2023

Alphabet (Google) verliert Marktwert, da Samsung Wechsel zu Bing erwägt

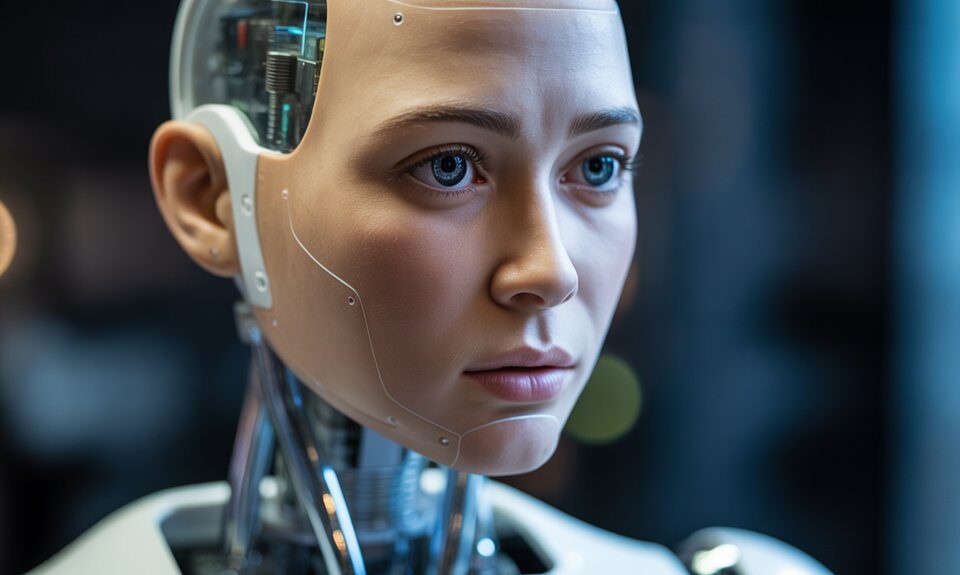

18/04/2023Es braucht einen Körper, um die Welt zu verstehen – warum ChatGPT und andere LLMs nicht wissen, was sie schreiben bzw. sagen

Große Sprachmodelle können Sprache nicht so verstehen wie Menschen, weil sie die Welt nicht wahrnehmen und begreifen können.

Von Arthur Glenberg, emeritierter Professor für Psychologie, Arizona State University & Cameron Robert Jones, Doktorand in Kognitionswissenschaften, University of California, San Diego

Als wir GPT‑3, ein extrem leistungsfähiges und beliebtes Sprachsystem mit künstlicher Intelligenz, fragten, ob du eher eine Papierkarte oder einen Stein benutzen würdest, um die Kohlen für ein Grillfest anzufachen, bevorzugte es den Stein.

Würdest du zum Glätten deines zerknitterten Rocks eine warme Thermoskanne oder eine Haarnadel nehmen ? GPT‑3 schlug die Haarnadel vor.

Und wenn du deine Haare für die Arbeit in einem Fast-Food-Restaurant bedecken musst, was ist dann besser : ein Papier-Sandwichpapier oder ein Hamburger-Brötchen ? GPT‑3 entschied sich für das Brötchen.

Warum trifft GPT‑3 diese Wahl, wenn die meisten Menschen die Alternative wählen ? Weil GPT‑3 die Sprache nicht so versteht wie Menschen.

Körperlose Worte

Einer von uns ist ein Psychologieforscher, der vor über 20 Jahren eine Reihe von Szenarien wie die oben genannten vorlegte, um das Verständnis eines Computermodells der Sprache aus dieser Zeit zu testen. Das Modell konnte sich nicht genau entscheiden, ob es Steine oder Karten zum Fächern von Kohlen verwenden sollte, während Menschen dies mühelos schafften.

Der andere von uns ist ein Doktorand der Kognitionswissenschaften, der zu einem Forscherteam gehörte, das vor kurzem dieselben Szenarien verwendete, um GPT‑3 zu testen. Obwohl GPT‑3 besser abschnitt als das ältere Modell, war es deutlich schlechter als der Mensch. Es hat die drei oben genannten Szenarien völlig falsch eingeschätzt.

GPT‑3, die Engine, die die erste Version von ChatGPT angetrieben hat, lernt über Sprache, indem sie aus einer Billion von Beispielen feststellt, welche Wörter auf welche anderen Wörter folgen. Die starken statistischen Regelmäßigkeiten in Sprachsequenzen ermöglichen es GPT‑3, eine Menge über Sprache zu lernen. Und dieses Sequenzwissen ermöglicht es ChatGPT oft, vernünftige Sätze, Aufsätze, Gedichte und Computercode zu produzieren.

Obwohl GPT‑3 extrem gut darin ist, die Regeln zu lernen, was in der menschlichen Sprache auf was folgt, hat es nicht die geringste Ahnung, was irgendeines dieser Wörter für einen Menschen bedeutet. Und wie sollte es auch ?

Der Mensch ist ein biologisches Wesen, das sich mit einem Körper entwickelt hat, der in der physischen und sozialen Welt agieren muss, um seine Aufgaben zu erfüllen. Sprache ist ein Werkzeug, das den Menschen dabei hilft. GPT‑3 ist ein künstliches Softwaresystem, das das nächste Wort vorhersagt. Es muss mit diesen Vorhersagen in der realen Welt nichts anfangen können.

Ich bin, also verstehe ich

Die Bedeutung eines Wortes oder Satzes steht in engem Zusammenhang mit dem menschlichen Körper : den Fähigkeiten des Menschen zu handeln, wahrzunehmen und Gefühle zu haben. Die menschliche Wahrnehmung wird durch die Verkörperung gestärkt. Das Verständnis eines Begriffs wie “Butterbrotpapier” umfasst beispielsweise das Aussehen, die Haptik und das Gewicht des Papiers und damit auch die Art und Weise, wie wir es verwenden können : zum Einpacken eines Brotes. Die Menschen verstehen auch, wie man es für unzählige andere Gelegenheiten verwenden kann, z. B. um es zu einem Ball zu zerknüllen, um Reifen zu spielen oder sich die Haare zu bedecken.

All diese Verwendungsmöglichkeiten ergeben sich aus der Natur des menschlichen Körpers und seinen Bedürfnissen : Menschen haben Hände, mit denen sie Papier falten können, einen Haarschopf, der etwa so groß ist wie eine Butterbrotdose, und das Bedürfnis, beschäftigt zu sein und deshalb Regeln wie das Bedecken der Haare zu befolgen. Das heißt, die Menschen verstehen es, Dinge auf eine Art und Weise zu nutzen, die in den Statistiken zum Sprachgebrauch nicht erfasst wird.

GPT‑3, sein Nachfolger GPT‑4 und seine Vettern Bard, Chinchilla und LLaMA haben keine Körper und können daher nicht selbst bestimmen, welche Gegenstände faltbar sind oder die vielen anderen Eigenschaften, die der Psychologe J.J. Gibson als Affordanzen bezeichnet. Mit den Händen und Armen des Menschen können Papierkarten eine Flamme entfachen und eine Thermoskanne Falten ausrollen.

Ohne Arme und Hände, ganz zu schweigen von der Notwendigkeit, bei der Arbeit zerknitterte Kleidung zu tragen, kann GPT‑3 diese Affordanzen nicht bestimmen. Er kann sie nur vortäuschen, wenn er im Wortstrom des Internets auf etwas Ähnliches gestoßen ist.

Wird eine KI mit großen Sprachmodellen jemals Sprache so verstehen wie Menschen ? Unserer Meinung nach nicht, ohne einen menschenähnlichen Körper, Sinne, Ziele und Lebensweisen zu haben.

Auf dem Weg zu einem Sinn für die Welt

GPT‑4 wurde nicht nur auf Text, sondern auch auf Bilder trainiert, so dass es statistische Beziehungen zwischen Wörtern und Pixeln lernen konnte. Obwohl wir unsere ursprüngliche Analyse mit GPT‑4 nicht durchführen können, weil es derzeit die Wahrscheinlichkeit, die es den Wörtern zuordnet, nicht ausgibt, beantwortete es die drei Fragen, die wir GPT‑4 stellten, richtig. Das könnte daran liegen, dass das Modell aus früheren Eingaben gelernt hat, oder daran, dass es größer und visueller geworden ist.

Du kannst jedoch weiterhin neue Beispiele konstruieren, um es zu verwirren, indem du dir Objekte mit überraschenden Eigenschaften ausdenkst, die dem Modell wahrscheinlich noch nicht begegnet sind. GPT‑4 sagt zum Beispiel, dass eine Tasse mit abgeschnittenem Boden besser geeignet ist, um Wasser aufzunehmen, als eine Glühbirne mit abgeschnittenem Boden.

Ein Modell, das Zugang zu Bildern hat, könnte so etwas sein wie ein Kind, das die Sprache – und die Welt – aus dem Fernsehen lernt : Es ist einfacher, als aus dem Radio zu lernen, aber für ein menschenähnliches Verständnis braucht es die Möglichkeit, mit der Welt zu interagieren.

Jüngste Forschungen haben diesen Ansatz aufgegriffen und Sprachmodelle darauf trainiert, Physiksimulationen zu erstellen, mit physischen Umgebungen zu interagieren und sogar Aktionspläne für Roboter zu entwickeln. Das verkörperte Sprachverständnis mag noch in weiter Ferne liegen, aber diese Art von multisensorischen interaktiven Projekten ist ein wichtiger Schritt auf dem Weg dorthin.

ChatGPT ist ein faszinierendes Werkzeug, das zweifelsohne für gute – und weniger gute – Zwecke eingesetzt werden wird. Aber glaube nicht, dass es die Worte versteht, die es ausspuckt, und schon gar nicht, dass es empfindungsfähig ist.

Dieser Artikel stammt von The Conversation, einer unabhängigen, gemeinnützigen Nachrichtenorganisation, die das Wissen von akademischen Experten weitergibt. Erfahre mehr über uns oder abonniere unsere wöchentlichen Newsletter Science & Technology Editors’ Picks.