Cutting-Edge AI Lab stellt den leistungsstarken Devin Assistenten vor

13/03/2024

Die KI-Vorschriften der EU haben weltweite Auswirkungen

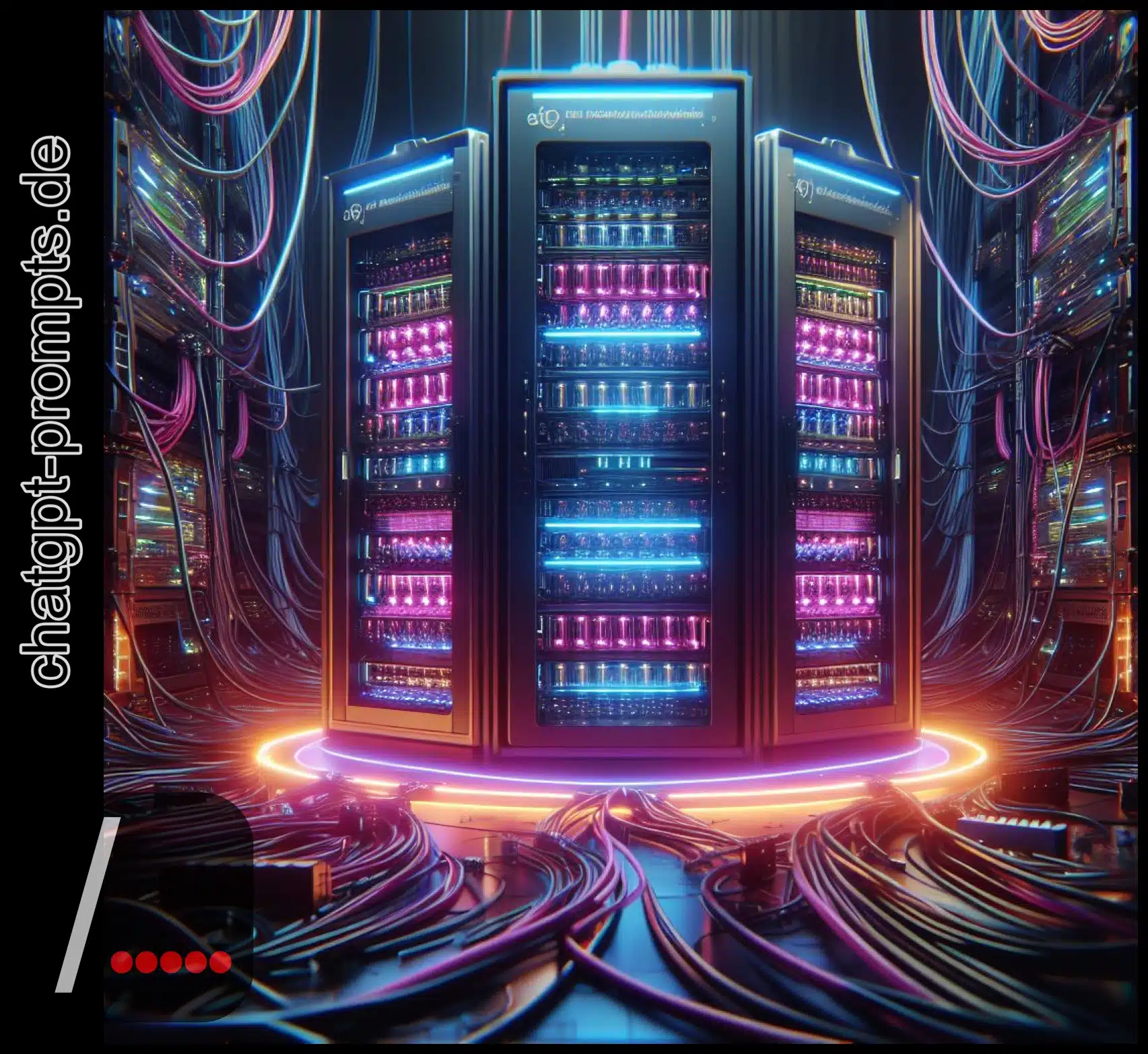

13/03/2024Die jüngste Enthüllung der neuesten KI-Infrastruktur-Upgrades von Meta stellt einen bedeutenden Schritt nach vorn im Bereich der künstlichen Intelligenz dar. Mit der Einführung des AI Research SuperCluster und der Integration der hochmodernen H100 GPUs zeigt Meta ein klares Bekenntnis zur Verbesserung der Rechenkapazitäten auf dem Weg zu Artificial General Intelligence (AGI). Diese Fortschritte unterstreichen nicht nur Metas Engagement, die Grenzen der Innovation zu erweitern, sondern signalisieren auch eine potenzielle Verschiebung in der Landschaft der KI-Fähigkeiten.

Während die Branche gespannt auf die Auswirkungen dieser Upgrades wartet, können wir nicht umhin, uns zu fragen : Welche neuen Möglichkeiten wird die verbesserte Infrastruktur von Meta in der sich ständig weiterentwickelnden Welt der künstlichen Intelligenz eröffnen ?

Metas Vision für die Zugänglichkeit von AGI

Meta widmet sich der Entwicklung künstlicher allgemeiner Intelligenz (Artificial General Intelligence, AGI), um modernste KI-Technologie weltweit zugänglich zu machen. Durch die vorrangige Förderung von AGI will Meta die Zugänglichkeit verbessern und sicherstellen, dass KI inklusiv und weithin verfügbar ist. Diese Vision steht im Einklang mit Metas Mission, die Vorteile fortschrittlicher KI zu demokratisieren und Innovationen in verschiedenen Branchen zu fördern.

Durch kontinuierliche Verbesserungen der KI-Infrastruktur und Fortschritte in der Forschung weist Meta den Weg in eine Zukunft, in der KI zu einem praktischen Werkzeug für Einzelpersonen und Organisationen weltweit wird, das bedeutende Fortschritte und positive Veränderungen bewirkt.

AI Research SuperCluster Details

Der AI Research SuperCluster ist eine hochmoderne Integration von erstklassigen Hardware- und Softwareressourcen, die Metas KI-Infrastrukturfähigkeiten verbessern. Diese fortschrittliche Architektur verfügt über skalierbare GPU-Cluster mit 16.000 NVIDIA A100-GPUs. Beim SuperCluster dreht sich alles um Effizienz, Produktivität und End-to-End-KI-Systeme, die eine schnelle Skalierbarkeit und flexible Bereitstellung ermöglichen.

Meta möchte die aus dem SuperCluster gewonnenen Erkenntnisse nutzen, um in Zukunft noch leistungsfähigere Cluster zu konstruieren. Diese Cluster verfügen über maßgeschneiderte Hardware, Software und Netzwerk-Fabrics, wie z. B. RoCE und InfiniBand-Fabrics mit 400 Gbit/s‑Endpunkten, die eine optimale Leistung und einen reibungslosen Betrieb bei der Verwaltung umfangreicher KI-Workloads gewährleisten.

Neue KI-Cluster mit H100-GPUs

Die Einführung neuer KI-Cluster mit 24.576 NVIDIA Tensor Core H100 GPUs stellt einen bedeutenden Fortschritt in der KI-Infrastruktur von Meta dar und baut auf dem Erfolg des AI Research SuperCluster auf. Diese Cluster bieten verbesserte Leistung und Fähigkeiten und setzen einen neuen Standard in der KI-Verarbeitungsleistung. Die wichtigsten Merkmale dieser neuen KI-Cluster sind :

- Verbesserte Deep-Learning-Fähigkeiten mit fortschrittlichen Tensor Core H100 GPUs.

- Verbesserte Effizienz beim Training komplexer KI-Modelle im großen Maßstab.

- Erhöhter Durchsatz für die Echtzeitverarbeitung großer Datensätze.

- Optimierte Infrastruktur für die nahtlose Bereitstellung modernster KI-Anwendungen.

Die Integration der H100 GPUs unterstreicht Metas Engagement, die Grenzen der KI-Forschung und ‑Entwicklung zu erweitern, was zu Innovationen in der künstlichen Intelligenz führt.

Maßgeschneiderte Netzwerk- und Berechnungsinfrastruktur

Die KI-Einrichtungen von Meta verfügen über eine hochmoderne kundenspezifische Netzwerk- und Recheninfrastruktur, die High-Performance-Computing neu definiert. Durch den Einsatz von Spitzentechnologie und innovativen Designprinzipien hat Meta ein System entwickelt, das in der Branche neue Maßstäbe setzt. Diese Infrastruktur nutzt maßgeschneiderte Hardware- und Softwarelösungen sowie spezialisierte Netzwerk-Fabrics wie RoCE und InfiniBand, die mit Endpunkten von 400 Gbit/s arbeiten, um skalierbare und effiziente KI-Cluster aufzubauen.

Die Hauptstärke dieser Infrastruktur liegt in ihrer Fähigkeit, schnell zu skalieren, sich an wechselnde Anforderungen anzupassen und die Bereitstellung in Rechenzentrumsflotten zu optimieren. Durch einen kohärenten Ansatz bei der Entwicklung von Netzwerk‑, Software- und Modellarchitekturen maximiert Meta die Ressourcennutzung und verbessert die allgemeine Systemleistung.

Grand Teton GPU Hardware-Plattform

Metas bahnbrechende Innovationen im Bereich der kundenspezifischen Netzwerk- und Recheninfrastruktur haben die Entwicklung und Optimierung der hochmodernen Grand Teton GPU Hardware Platform ermöglicht. Diese Plattform führt bedeutende Hardware-Fortschritte und Leistungssteigerungen ein, die die Entwicklung der KI-Infrastruktur von Meta vorantreiben.

Zu den wichtigsten Merkmalen der Grand Teton GPU-Hardware-Plattform gehören :

- Verbesserte Rechenleistung für die effiziente Verarbeitung komplexer KI-Algorithmen.

- Verbesserte Effektivität bei der Verarbeitung umfangreicher Datenaufgaben.

- Verbesserte Skalierbarkeit und Flexibilität zur Unterstützung einer Vielzahl von KI-Workloads.

- Integration fortschrittlicher Funktionen für ein beschleunigtes Modelltraining.

Bedeutung von Speicherlösungen

Eine robuste Speicherinfrastruktur ist entscheidend für ein reibungsloses KI-Training, da die Datenmengen stark ansteigen. Skalierbarer Speicher ist der Schlüssel zur Bewältigung der riesigen Datensätze, die für fortschrittliche KI-Modelle benötigt werden. Metas FUSE API und Tectonic Distributed Storage sind auf Flash-Medien zugeschnitten und gewährleisten einen schnellen Datenzugriff. Die Zusammenarbeit mit Hammerspace erhöht die Iterationsgeschwindigkeit, die für den KI-Fortschritt entscheidend ist. YV3 Sierra Point Server ermöglichen eine durchsatzstarke Speicherung im Exabyte-Bereich für kontinuierliches Training mit synchronisierten Checkpoints. Metas Fokus auf Flash-Optimierung und skalierbaren Speicher zeigt das Engagement, die sich entwickelnden Anforderungen der KI zu erfüllen.

Engagement für offene KI-Innovation

Metas Engagement für offene KI-Innovation zeigt sich in seiner starken Unterstützung für kollaborative Hardware- und Softwarelösungen. Als Gründungsmitglied von OCP und aktiver Mitwirkender an PyTorch setzt Meta auf Open-Source-Technologien, um den Fortschritt im Bereich der KI voranzutreiben. Mit der Gründung der Open Innovation AI Research Community und der AI Alliance fördert Meta eine Kultur der Zusammenarbeit und des Fortschritts in der Branche. Dieses Engagement unterstreicht Metas proaktiven Ansatz, Innovationen voranzutreiben und gleichzeitig ethische und nachhaltige Praktiken einzuhalten.

Zukunftspläne für die Expansion

Meta bereitet sich auf signifikantes Wachstum und KI-Fortschritte vor, indem es seine Infrastruktur durch eine erhebliche Aufstockung der NVIDIA H100s zur Steigerung der Rechenleistung ausbaut. Der Plan sieht vor, die Anzahl der NVIDIA H100s bis 2024 auf 350.000 zu erhöhen, was einer Gesamtrechenleistung von fast 600.000 H100s entspricht. Mit diesem strategischen Schritt werden die Herausforderungen der Skalierbarkeit direkt angegangen, um sicherzustellen, dass die Infrastruktur die sich entwickelnden Anforderungen von KI-Workloads effizient bewältigen kann.

Ständige Bewertung der Infrastruktur

Die kontinuierliche Bewertung der Leistung und Effizienz der KI-Infrastrukturkomponenten ist entscheidend für die Aufrechterhaltung einer erstklassigen Funktionalität und Skalierbarkeit in der fortschrittlichen Rechenumgebung von Meta. Die ständige Bewertung der Infrastruktur umfasst mehrere wichtige Schritte :

- Regelmäßige Leistungsbeurteilungen : Durchführung häufiger Leistungsbewertungen, um Engpässe und verbesserungswürdige Bereiche zu ermitteln.

- Skalierbarkeitsverbesserungen : Implementierung von Skalierbarkeitsverbesserungen, um mit den wachsenden Anforderungen an die KI-Infrastruktur Schritt zu halten.

- Überwachung der Ressourcenauslastung : Verfolgung der Ressourcennutzung zur Maximierung von Effizienz und Kosteneffizienz.

- Nutzung fortschrittlicher Analysen : Nutzung modernster Analysetools, um Einblicke in das Systemverhalten und Leistungstrends zu gewinnen.

Optimierungsstrategien für das Training

Optimierungsstrategien sind für das Training in der KI-Infrastruktur von entscheidender Bedeutung, da sie die Effizienz und Leistung von großen maschinellen Lernmodellen erheblich steigern. Ziel ist es, die Skalierbarkeit zu verbessern und die Leistung durch Schlüsseltechniken wie verteiltes Training, Mixed Precision Computing und Modellparallelität zu optimieren. Diese fortschrittlichen Methoden ermöglichen es Unternehmen, große Datensätze und komplexe Modelle effektiv zu verwalten.

Um die Trainingseffizienz zu verbessern, ist es wichtig, Datenpipelines zu optimieren, Hardwarebeschleuniger zu nutzen und Hyperparameter fein abzustimmen. Die kontinuierliche Überwachung und Anpassung dieser Strategien ist unerlässlich, um mit den sich entwickelnden KI-Arbeitslasten Schritt zu halten und Spitzenleistungen zu gewährleisten. Ein umfassender Ansatz für Optimierungsstrategien ist entscheidend, um das Potenzial der KI-Infrastruktur zu maximieren und Fortschritte in der künstlichen Intelligenz voranzutreiben.