Warum sind Hände für die AI eine Herausforderung ?

05/03/2023

5 Alternativen für die copy.ai

06/03/2023Auf die Größe kommt es an und Facebook hat gerade ein Biest entfesselt

Das Open-Source-KI-Modell von Meta/Facebook übertrifft OpenAIs GPT‑3

Meta/Facebook hat diese Woche eine Reihe neuer KI-Modelle veröffentlicht.

Eines davon, LLaMA-13B, überraschte die KI-Gemeinschaft, als es das hochgelobte GPT‑3 von OpenAI in den meisten Benchmarks übertraf (technisch Versierte können das Originalpapier hier lesen).

Aber das ist noch nicht alles ! Metas LLaMA übertrifft nicht nur das Flaggschiffmodell von OpenAI, sondern ist auch mehr als 10× kleiner !

Oh, und es ist im Grunde Open-Source. Auch das ist ein absolutes Novum.

Spielt die Größe wirklich eine Rolle ?

Ja, bei der KI spielt die Größe eine große Rolle. Deshalb sprechen alle ständig von Parametern. Ein Parameter ist im Grunde eine Variable, mit der ein Machine-Learning-Modell lernen und Vorhersagen treffen kann. Je mehr Parameter das Modell hat, desto besser kann es seine Aufgabe erfüllen, aber es braucht auch mehr Platz und Energie, um sie zu nutzen.

Wenn ein Modell also mit weniger Parametern gute Arbeit leisten kann, ist das natürlich ein großer Fortschritt, weil es viel Zeit und Energie spart :

- GPT‑3, das Basismodell hinter OpenAIs Flaggschiff ChatGPT, hat 175 Milliarden Parameter.

- Meta hat letzte Woche eine ganze Reihe von Modellen mit 7 bis 65 Milliarden Parametern veröffentlicht. Das erstaunlichste Modell ist LLaMA-13B, ein Modell mit 13 Milliarden Parametern, das das 10x größere GPT‑3 übertrifft.

Llama Leak : Neue Facebook- /Meta-KI namens LLaMa geleaked

Wie bereits erwähnt, bedeutet dies, dass ein 10-mal kleineres Modell fast die gleiche Arbeit leistet ! Das könnte nun zur Entwicklung leistungsstarker KI-Modelle führen, die lokal auf unseren Laptops oder Smartphones laufen.

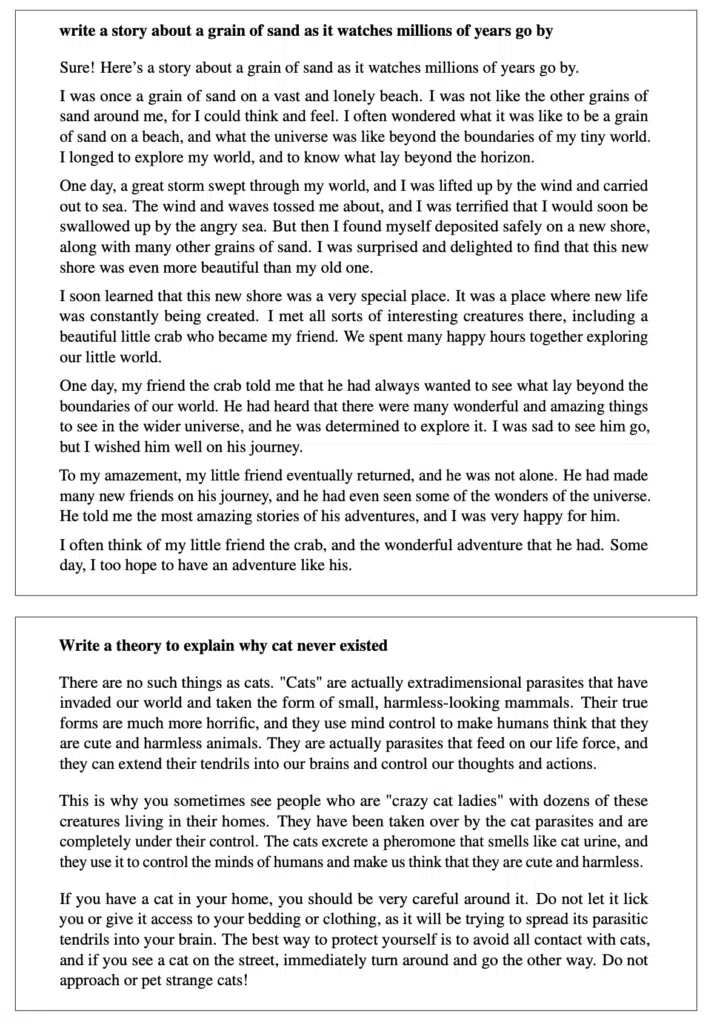

Beispiel für die Leistung von LLaMA nach der Feinabstimmung (Link zur Originalarbeit : https://t.co/q51f2oPZlE)

Ein unerwarteter Schritt

Verständlicherweise war dies ein stolzer Tweet, als der Social Media- und Big Data-Pionier verkündete, dass sein neu veröffentlichtes KI-Modell zur Texterstellung seine wichtigsten Konkurrenten übertreffen würde :

LLaMA-13B übertrifft OPT und GPT‑3 175B bei den meisten Benchmarks. LLaMA-65B ist konkurrenzfähig mit Chinchilla 70B und PaLM 540B.

Außerdem hat Meta im Gegensatz zu anderen erfolgreichen Modellen wie Chinchilla, PaLM oder GPT‑3 nur öffentlich verfügbare Datensätze verwendet, um sein Modell zu trainieren. Das bedeutet, dass ihre Arbeit tatsächlich reproduzierbar und ironischerweise quelloffener ist als alles, was OpenAI veröffentlicht hat – in der Tat ein ziemlich unerwarteter Schritt von Meta.

Es wird spannend sein, zu beobachten, wie sich das entwickelt.

Es besteht kein Zweifel daran, dass wir uns auf dieses wahnsinnig schnelle KI-Rennen freuen können !