Verbesserungen in ZimmWriter 9.0 : Verbessertes KI-Schreiben und Funktionen

24/11/2023

DS Automobiles verbessert das Fahrerlebnis mit der Chatgpt-Integration

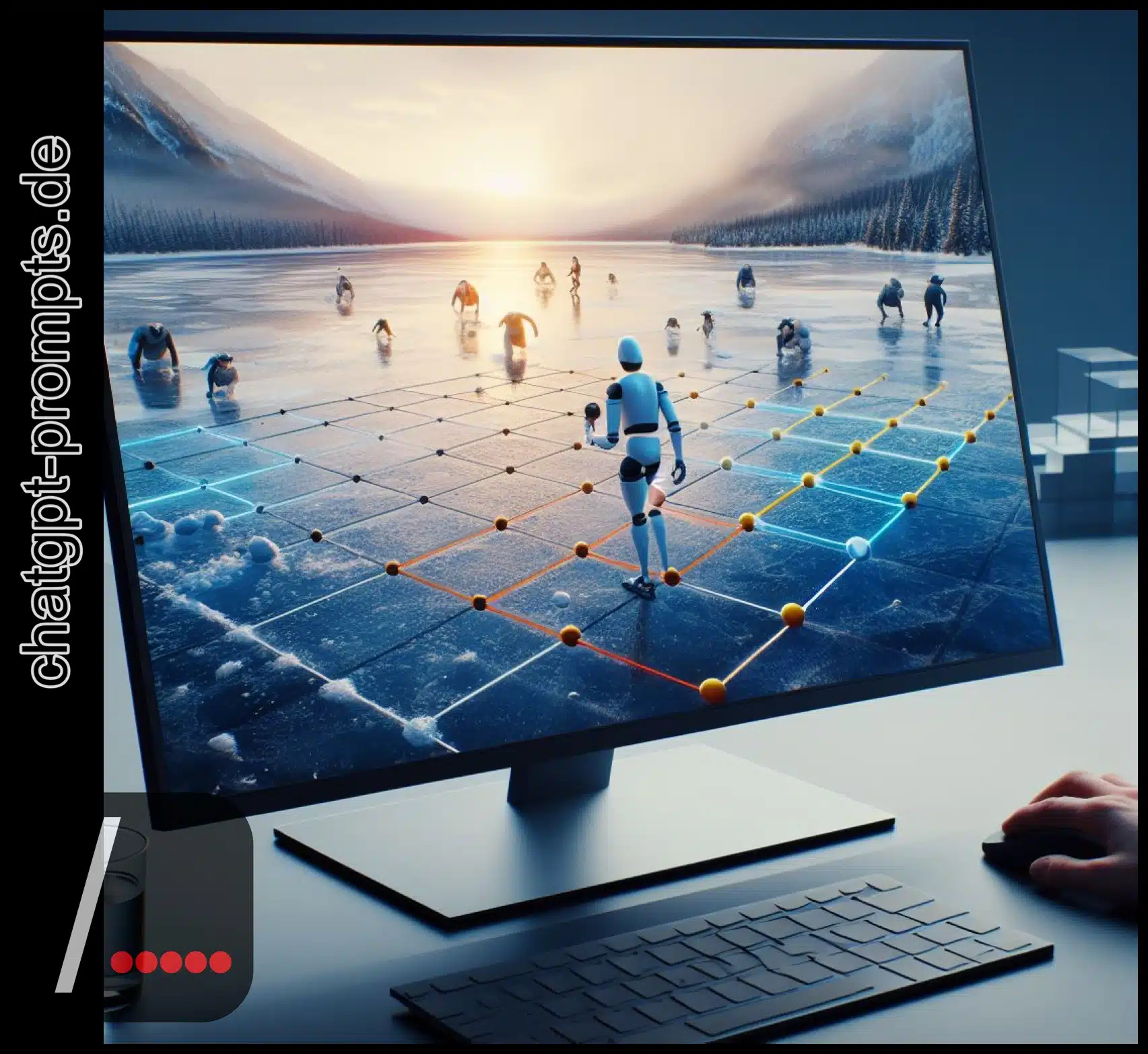

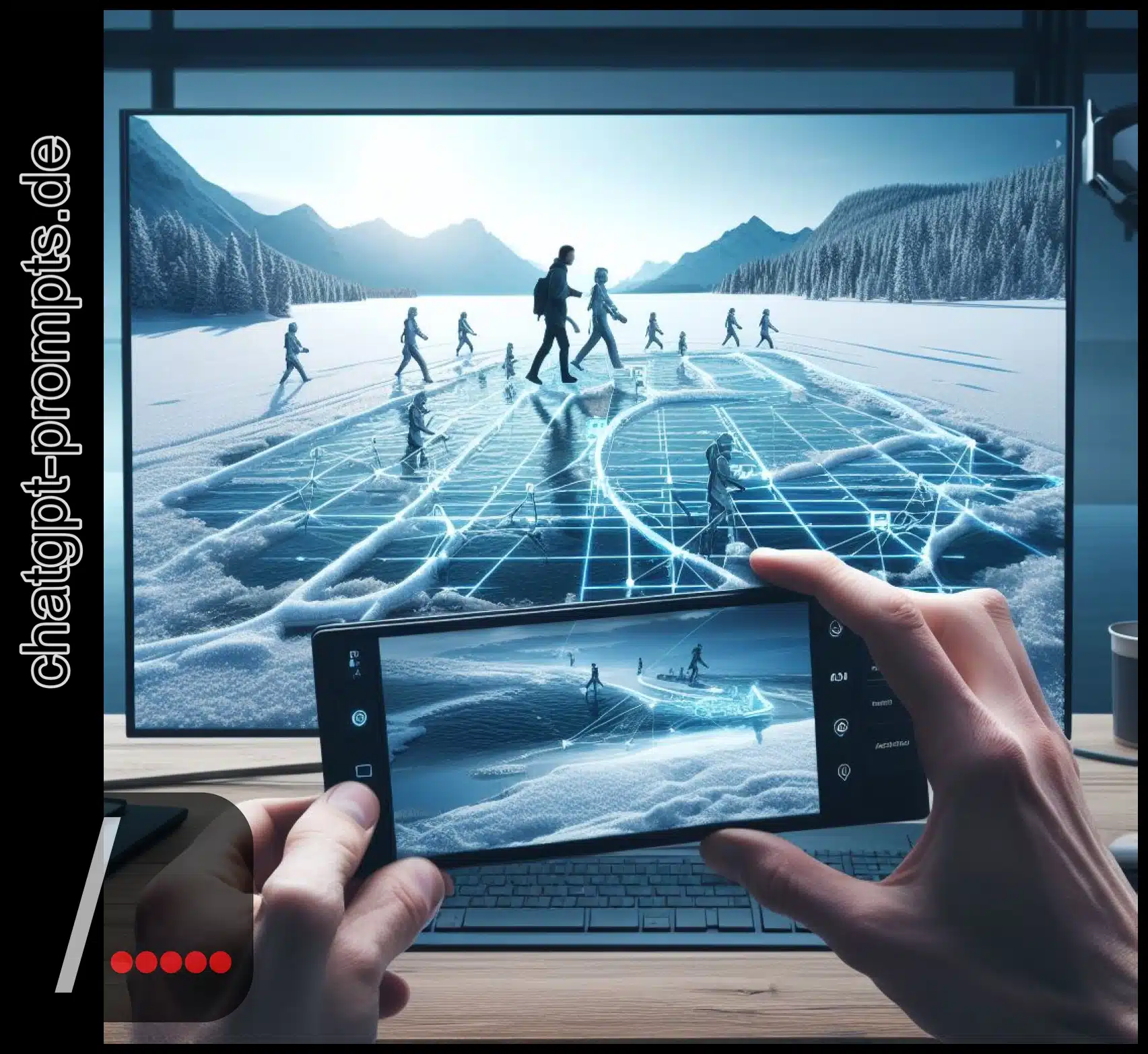

26/11/2023Begeben Sie sich auf eine Reise, um die Frozen Lake Challenge zu meistern, indem Sie Q‑learning lernen, einen leistungsstarken Algorithmus aus dem Bereich des verstärkenden Lernens. Bei dieser spannenden Aufgabe geht es darum, auf strategische Weise durch sichere Bereiche und Hindernisse zu navigieren.

Erforschen Sie die Details der Q‑Tabellen-Darstellung und der Trainingstechniken sowie die wichtige Rolle des Epsilon-Greedy-Algorithmus, der Lernrate und des Diskontierungsfaktors. Jenseits dieses eisigen Terrains findet das Reinforcement Learning Anwendungen in verschiedenen Bereichen wie autonomes Fahren, Spiele und Empfehlungssysteme.

Die Beherrschung des Q‑Learnings ermöglicht nicht nur die Bewältigung spezifischer Herausforderungen, sondern öffnet auch die Türen zu einer breiten Palette von Anwendungen in der realen Welt und befähigt Menschen mit außergewöhnlichen Fähigkeiten.

Grundlagen des Reinforcement Learning

Um Q‑Learning zu beherrschen und die Herausforderungen in dynamischen Umgebungen zu meistern, ist es wichtig, die Grundlagen des Reinforcement Learning zu verstehen. Das Gleichgewicht zwischen Exploration und Ausnutzung ist entscheidend für eine effektive Entscheidungsfindung in diesem Bereich. Markov-Entscheidungsprozesse (MDPs) bilden den mathematischen Rahmen für das Verstärkungslernen und bieten einen strukturierten Ansatz zur Modellierung der Entscheidungsfindung in unsicheren Umgebungen. Das Verständnis von MDPs bietet Praktikern Einblicke in das Zusammenspiel von Aktionen, Zuständen und Belohnungen und bildet die Grundlage für Algorithmen des Verstärkungslernens.

Das Erreichen des richtigen Gleichgewichts zwischen Exploration und Ausbeutung ermöglicht es Agenten, sich in komplexen Umgebungen effektiv zu bewegen, fundierte Entscheidungen zu treffen und dabei kontinuierlich zu lernen und ihre Strategien zu verbessern. Die Beherrschung dieser Grundlagen bildet die Grundlage für die Bewältigung von Aufgaben wie der Frozen Lake-Herausforderung, die versierte Verstärkungslerntechniken erfordern.

Die Frozen Lake-Umgebung

Das Verständnis der Frozen Lake-Umgebung ist entscheidend für die Beherrschung des Q‑Learnings und die Festigung der Grundlagen des Reinforcement Learning. Die Erkundung verschiedener Belohnungsstrukturen und die Analyse der Auswirkungen verschiedener Strategien zur Handlungsauswahl sind entscheidende Komponenten für die Navigation in dieser anspruchsvollen Umgebung. Der gefrorene See stellt ein gefährliches Terrain dar, mit sicheren gefrorenen Oberflächen, tückischen Löchern und einem weit entfernten Ziel.

Der Agent muss strategisch durch die Umgebung navigieren und dabei Entscheidungen treffen, die das Risiko minimieren und den Nutzen maximieren. In diesem Zusammenhang kommt der Wahl der Handlungsauswahlstrategien und der Belohnungsstrukturen eine zentrale Bedeutung zu.

Diese Entscheidungen wirken sich direkt auf den Lernprozess und die Fähigkeit des Agenten aus, den Gefrorenen See zu bezwingen. Wenn man sich mit diesen Aspekten befasst, erhält man wertvolle Einblicke in die komplizierte Dynamik des Q‑Learnings in der Frozen Lake-Umgebung.

Q‑Tabellen-Darstellung

Sobald der Agent die Umgebung des gefrorenen Sees verstanden hat, konzentriert er sich auf die Verwendung einer Q‑Tabellen-Darstellung, um das schwierige Terrain effektiv zu navigieren. In dieser Phase ist es wichtig, verschiedene Möglichkeiten zur Darstellung von Aktionen zu erforschen und die Auswirkungen verschiedener Belohnungsstrukturen zu analysieren. Die Q‑Tabelle ordnet den Aktionen in jedem Zustand Qualitätswerte zu und leitet den Entscheidungsprozess des Agenten. Durch Verstärkungslernen wird die Q‑Tabelle aktualisiert, wenn der Agent mit der Umgebung interagiert. Während des Trainings werden Aktionen auf der Grundlage des höchsten Q‑Wertes oder durch zufällige Erkundung ausgewählt, wobei ein Gleichgewicht zwischen Ausbeutung und Erkundung hergestellt wird. Die Q‑Werte werden auf der Grundlage der erhaltenen Belohnungen und des potenziellen Wertes im nächsten Zustand kontinuierlich aktualisiert. Diese Darstellung bildet die Grundlage für den Agenten, um optimale Strategien zu erlernen und die Frozen Lake Herausforderung zu meistern.

Überblick über den Trainingsprozess

Wie kommt der Trainingsprozess beim Q‑Learning der Entscheidungsfindung des Agenten in der Frozen Lake-Umgebung zugute ? Der Trainingsprozess beim Q‑Learning nutzt verschiedene Strategien, um die Entscheidungsfindung des Agenten zu verbessern. Dabei werden verschiedene Erkundungsstrategien erprobt, wie z. B. die Nutzung des höchsten Q‑Wertes oder die zufällige Erkundung, um ein umfassendes Lernen zu gewährleisten. Die Bewertung der Auswirkungen von Lernrate und Diskontierungsfaktor auf die Trainingsleistung ist von entscheidender Bedeutung.

Die Lernrate bestimmt das Ausmaß der Veränderung des ursprünglichen Q‑Wertes, während der Abzinsungsfaktor die Berücksichtigung zukünftiger Belohnungen durch den Agenten beeinflusst. Diese Faktoren spielen eine zentrale Rolle bei der Gestaltung der Entscheidungsfähigkeit des Agenten und der Optimierung seiner Leistung in der anspruchsvollen Frozen Lake-Umgebung.

Durch die Einbeziehung dieser Elemente befähigt der Trainingsprozess den Agenten, sich in der Umgebung effizient zu bewegen und fundierte Entscheidungen zu treffen.

Epsilon-Greedy-Algorithmus

Beim Q‑Learning, insbesondere in der Frozen Lake-Umgebung, beinhaltet der Trainingsprozess die Implementierung des Epsilon-Greedy-Algorithmus, um ein effektives Gleichgewicht zwischen Exploration und Exploitation während der Aktionsauswahl zu erreichen. Dieser Algorithmus geht den Kompromiss zwischen Exploration und Exploitation an, indem er dem Agenten die Möglichkeit gibt, zwischen einer zufälligen Aktion mit einer Wahrscheinlichkeit von Epsilon und der Aktion mit dem höchsten Q‑Wert mit einer Wahrscheinlichkeit von (1‑Epsilon) zu wählen.

Dieses Gleichgewicht der Zufälligkeit ist für den Agenten von entscheidender Bedeutung, um die optimale Handlungsauswahl zu erkunden und gleichzeitig die kumulativen Belohnungen zu maximieren. Da epsilon während des Trainings allmählich durch linearen Abfall abnimmt, geht der Algorithmus nahtlos von der Exploration zur Ausbeutung über. Dieser Ansatz garantiert, dass der Agent nicht nur die Umgebung effizient erkundet, sondern auch zu einer optimalen Handlungsauswahl konvergiert, was letztendlich zu einer geschickten Navigation in der Frozen Lake-Umgebung führt.

Trainingstechniken

Beim Verstärkungslernen werden verschiedene Trainingsmethoden eingesetzt, um die Entscheidungsfindung des Agenten in einer bestimmten Umgebung zu verbessern. Das Erreichen eines Gleichgewichts zwischen den Belohnungen ist beim Verstärkungslernen von entscheidender Bedeutung und wird durch das Dilemma zwischen Exploration und Ausbeutung angesprochen. Der Epsilon-Greedy-Algorithmus bewältigt dieses Dilemma, indem er die Zufälligkeit der Aktionsauswahl reguliert und allmählich von Exploration zu Exploitation übergeht.

Das lineare Abklingen von Epsilon verbessert dieses Gleichgewicht weiter, indem es die Zufälligkeit nach jeder Episode reduziert. Die spärlichen Belohnungen werden durch kleinere Zwischenbelohnungen ergänzt, um den Lernprozess zu steuern. In der rutschigen Variante von Frozen Lake wird die Zufälligkeit eingeführt, was eine zusätzliche Herausforderung für den Agenten darstellt. Diese Trainingstechniken spielen eine wichtige Rolle bei der Entscheidungsfindung des Agenten und gewährleisten ein strategisches Gleichgewicht zwischen der Erkundung neuer Möglichkeiten und der Nutzung des vorhandenen Wissens zur Maximierung der kumulativen Belohnungen.

Schlüsselfaktoren des Q‑Learnings

Das Verständnis der Frozen Lake-Umgebung ist von entscheidender Bedeutung, und die Schlüsselfaktoren des Q‑Learnings bieten wesentliche Einblicke in die Effektivität und Leistung des Algorithmus. Beim Q‑Learning ist es entscheidend, ein Gleichgewicht zwischen Exploration und Exploitation zu erreichen. Der Epsilon-Greedy-Algorithmus, der den Grad der Zufälligkeit bei der Aktionsauswahl bestimmt, spielt eine zentrale Rolle bei der Herstellung dieses Gleichgewichts.

Die optimale Aktionswertfunktion, die durch die Q‑Tabelle dargestellt wird, ist von grundlegender Bedeutung, wenn es darum geht, den Agenten dazu anzuleiten, Entscheidungen zu treffen, die den langfristigen Nutzen maximieren. Darüber hinaus haben die Lernrate und der Diskontierungsfaktor erhebliche Auswirkungen auf die Konvergenz und Stabilität des Q‑Learning-Algorithmus. Die Beherrschung des Q‑Learnings und die Bewältigung komplexer Herausforderungen, wie z. B. der Frozen Lake-Umgebung, erfordern ein tiefes Verständnis und eine Feinabstimmung dieser Schlüsselfaktoren.

Anwendungen des Reinforcement Learning

Um Herausforderungen wie die Navigation in der Frozen Lake-Umgebung mithilfe von Q‑Learning effektiv zu meistern, ist ein gründliches Verständnis der Schlüsselfaktoren unerlässlich. Diese Prinzipien haben weitreichende Anwendungen, darunter autonomes Fahren, Energieoptimierung, Spiele, Robotersteuerung und Empfehlungssysteme. Verstärkungslernen findet in der Praxis Anwendung in Szenarien wie der Entscheidungsfindung für autonome Fahrzeuge in dynamischen Umgebungen, der Optimierung von Energieverbrauchsmustern und der Beherrschung komplexer Strategien durch Spielagenten.

Es ist jedoch zu beachten, dass das verstärkende Lernen auch Grenzen hat, wie z. B. hohe Rechenanforderungen, Empfindlichkeit gegenüber Hyperparametern und die Schwierigkeit spärlicher Belohnungen in bestimmten Umgebungen. Trotz dieser Einschränkungen liegen die Vorteile des verstärkenden Lernens bei der Bewältigung komplexer Entscheidungsprobleme auf der Hand und haben das Potenzial, Innovationen bei autonomen Systemen und intelligenten Entscheidungsprozessen in verschiedenen Branchen voranzutreiben.