DeepSeek Coder V2 : Fortschritte bei Open-Source-Codiermodellen

21/06/2024

Urheberrecht und faire Nutzung in der KI-Entwicklung verstehen

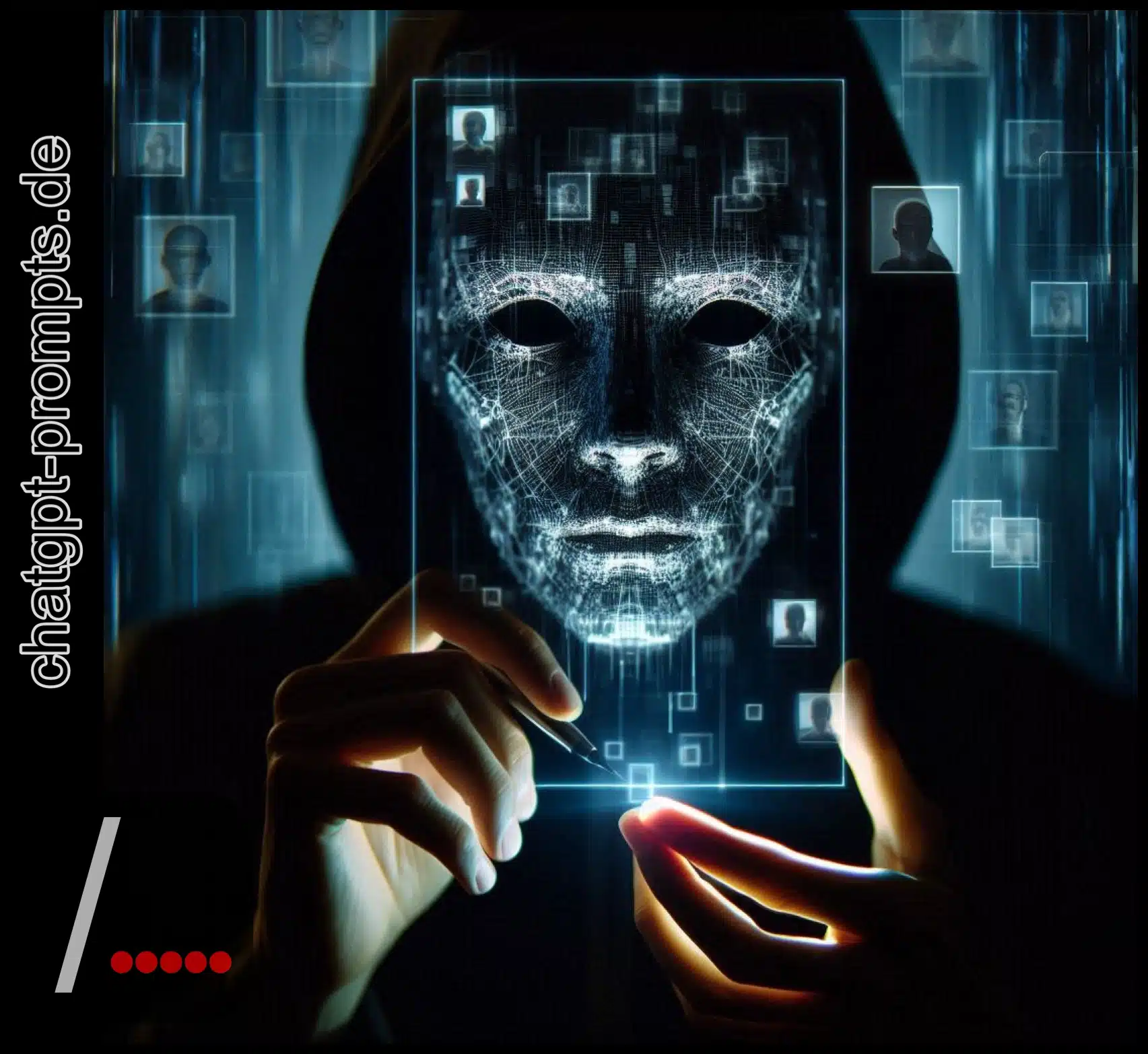

01/07/2024Das Aufkommen von Betrug mit synthetischen Identitäten und Deepfake-Betrug verändert die digitale Sicherheitslandschaft und stellt sowohl Einzelpersonen als auch Organisationen vor noch nie dagewesene Herausforderungen. Da Cyberkriminelle fortschrittliche KI-Technologien nutzen, um äußerst überzeugende gefälschte Identitäten zu erstellen und audiovisuelle Inhalte zu manipulieren, hat das Potenzial für Ausbeutung und Betrug erheblich zugenommen. Dieses Phänomen bedroht nicht nur die Privatsphäre, sondern untergräbt auch die Integrität digitaler Interaktionen. Es ist daher unerlässlich, die komplexen Methoden dieser Betrüger und die fortschrittlichen Strategien, die zu ihrer Bekämpfung erforderlich sind, zu untersuchen. Wie können wir auf diesem sich ständig weiterentwickelnden digitalen Schlachtfeld die Oberhand behalten ?

Stimmenklonen und Phishing

Durch den Einsatz fortschrittlicher Sprachsynthese-Technologien können Betrüger heute überzeugende Audio-Imitationen von nur wenigen Sekunden aufgezeichneter Sprache erstellen und so ihre Phishing-Taktiken wirksam verbessern. Mit Hilfe von KI-gestützter Sprachmanipulation können diese Betrüger Nachrichten produzieren, die auf unheimliche Weise vertraut klingen und sich wie geliebte Menschen in Not oder Bedrängnis anhören. Personalisierte Phishing-Techniken werden durch KI auf eine neue Ebene gehoben, da Betrüger persönliche Daten aus Sicherheitsverletzungen nutzen, um ihre betrügerischen Nachrichten zu personalisieren. Stellen Sie sich vor, Sie erhalten einen Anruf, und die Stimme am anderen Ende der Leitung ist eindeutig die eines engen Freundes, der dringend um Hilfe bittet. Die Präzision dieser synthetischen Stimmen kann leicht das Urteilsvermögen trüben und ein Gefühl von Dringlichkeit und Vertrauen erwecken. Diese technologische Raffinesse des Phishing erfordert eine wachsame und informierte Reaktion, um die persönliche Freiheit zu schützen.

Identitätsbetrug mit KI

Während künstliche Stimmen die Phishing-Taktiken optimieren, entwickelt sich der KI-gesteuerte Identitätsbetrug zu einer ernsthaften Bedrohung, bei der persönliche Daten und Sprachaufzeichnungen genutzt werden, um überzeugende digitale Identitäten zu erstellen. Stellen Sie sich eine Welt vor, in der KI-gesteuerter Identitätsbetrug mit synthetischen Identitäten Ihre Stimme mit nur einem kurzen Audioausschnitt imitieren kann. Betrüger, die mit Daten aus Datenschutzverletzungen ausgestattet sind, erstellen diese digitalen Doppelgänger, um sowohl Kundendienstmitarbeiter als auch ahnungslose Freunde zu täuschen. Dies ist keine Science Fiction, sondern Realität. Diese künstlichen Identitäten können auf persönliche Konten zugreifen, Geld verlangen oder sogar sensible Informationen manipulieren, so dass sich die Opfer in einem Netz der Täuschung gefangen fühlen. Die Zunahme des KI-Identitätsbetrugs stellt unser Sicherheitsempfinden in Frage und unterstreicht die dringende Notwendigkeit fortschrittlicher Schutzmaßnahmen.

Erkennung von KI-generierten Deepfakes

Die Erkennung von KI-generierten Deepfakes wird aufgrund der Fortschritte im Bereich der künstlichen Intelligenz und der maschinellen Lerntechnologien immer schwieriger. Die Methoden zur Erkennung von Deepfakes entwickeln sich zwar weiter, müssen aber mit diesen raffinierten Fälschungen Schritt halten. Bei der Echtheitsprüfung durch KI werden subtile Unstimmigkeiten wie unnatürliches Blinzeln oder Gesichtsverzerrungen untersucht. Mit der Verbesserung der KI werden diese Indikatoren jedoch immer schwieriger zu erkennen. Stellen Sie sich vor, Sie müssten das Werk eines Meistermalers von einer perfekten Kopie unterscheiden. Keine leichte Aufgabe ! Forscher verwenden Algorithmen des maschinellen Lernens, um selbst kleinste Anomalien zu erkennen, so wie ein Künstler einen gefälschten Pinselstrich erkennt. Doch je überzeugender Deepfakes werden, desto mehr verschwimmen die Grenzen zwischen Realität und Fiktion – eine ernsthafte Bedrohung für unsere Wahrnehmung von Wahrheit und Freiheit.

Deepfake-Erpressung

Mit der zunehmenden Verbreitung der Deepfake-Technologie ist eine neue und beunruhigende Form der Cybererpressung entstanden, die als Deepfake-Erpressung bekannt ist. Stellen Sie sich vor, Sie stoßen auf ein gefälschtes Nacktfoto von sich, das ohne Ihre Zustimmung im Internet verbreitet wird. Dieses beängstigende Szenario ist für viele Menschen Realität, denn Betrüger nutzen die Deepfake-Technologie zur Erpressung. Die Freiheit und Würde des Opfers stehen auf dem Spiel, aber es gibt Hoffnung. Es können rechtliche Schritte eingeleitet werden, um gegen diese böswilligen Handlungen vorzugehen und die Entfernung solcher schädlichen Inhalte zu erzwingen. Dieser Kampf um Gerechtigkeit zeigt, wie wichtig es ist, wachsam und informiert zu bleiben, um sicherzustellen, dass die persönliche Freiheit nicht durch diese digitalen Bedrohungen beeinträchtigt wird. Denken Sie daran, dass Wissen und Rechtsmittel mächtige Werkzeuge im Kampf gegen diese beunruhigende Bedrohung sind.

Schutz vor Deepfake-Betrug

Der Schutz vor Deepfake-Betrug erfordert einen proaktiven Ansatz in Bezug auf Cybersicherheit und Wachsamkeit bei der Überprüfung der Authentizität von Kommunikation. Stellen Sie sich eine Welt vor, in der eine einfache Sprachaufnahme als Waffe eingesetzt werden kann. Das ist unsere Realität. Ergreifen Sie Online-Sicherheitsmaßnahmen wie die mehrstufige Authentifizierung – sie ist Ihre digitale Festung. Seien Sie der Sherlock Holmes Ihres Posteingangs und hinterfragen Sie jeden Link und jeden Anhang. Bleiben Sie neugierig und behalten Sie Ihr technisches Bewusstsein im Auge. Wenn Sie die Tricks der Betrüger kennen, sind Sie im Vorteil.

Stellen Sie sich vor, Sie sind ein digitaler Ritter, der seine virtuelle Domäne mit einer glänzenden Rüstung schützt. Melden Sie verdächtige Aktivitäten und denken Sie daran : Ein bisschen Skepsis schützt. Seien wir wachsam, informiert, frei und verstehen wir das digitale Zeitalter mit Selbstvertrauen und einer Prise Humor.