OpenAI erhält 2 Millionen Chips von Oracle für den Stargate-Ausbau

23/07/2025

Mathe-Krieg : OpenAI und Google streiten um Olympiade-Ruhm

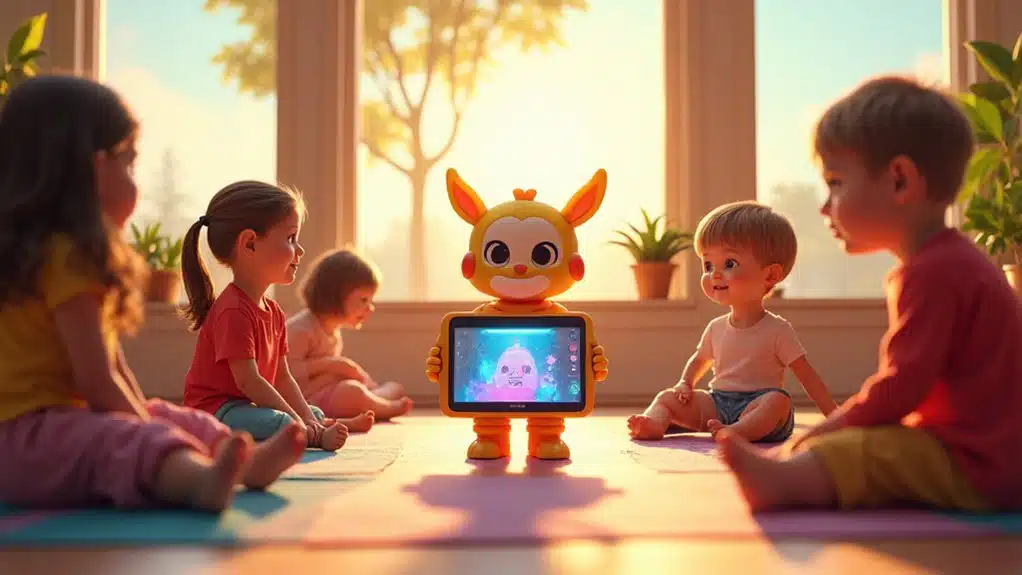

23/07/2025Elon Musk hat Pläne für „Baby Grok” vorgestellt, einen spezialisierten KI-Chatbot, der nur für Kinder entwickelt wurde. Dieser kinderfreundliche Assistent zielt darauf ab, das Lernen über Wissenschaft und Natur sowohl sicher als auch unterhaltsam zu gestalten. Das Projekt umfasst starke Sicherheitsfilter und elterliche Aufsichtsfunktionen, um die wachsenden Bedenken bezüglich der KI-Exposition für junge Nutzer zu berücksichtigen. Jedoch bleiben mehrere wichtige Fragen darüber bestehen, wie diese Technologie tatsächlich Kinder schützen wird, während sie ihre Bildungsversprechen erfüllt.

Kinderfreundliche KI-Lernplattform in Entwicklung

Wie können sich Eltern sicher fühlen, wenn ihre Kinder KI-Chatbots verwenden ? Elon Musk und sein Team bei xAI entwickeln eine Antwort mit Baby Grok, einem neuen KI-Chatbot, der speziell für Kinder entwickelt wurde.

Diese kinderfreundliche Version zielt darauf ab, Familien das zu geben, was sie gefordert haben : sichere Technologie, die Kindern beim Lernen hilft, ohne sich Sorgen machen zu müssen. Im Gegensatz zur Erwachsenenversion von Grok konzentriert sich Baby Grok vollständig auf Bildung und unterhaltsame Aktivitäten, denen Eltern vertrauen können.

Der neue Chatbot spezialisiert sich darauf, das Lernen für junge Köpfe aufregend zu machen. Er erklärt Wissenschaits- und Naturthemen auf einfache Weise, die Kinder verstehen können. Stellen Sie es sich als geduldigen Tutor vor, der nie müde wird, “Warum”-Fragen zu beantworten. Die KI verwendet alltägliche Sprache, um Kindern zu helfen, neue Ideen zu entdecken, während sie Gespräche leicht und ansprechend hält.

Sicherheit steht im Mittelpunkt dieses Projekts. Baby Grok enthält starke Filter, die alles blockieren, was für Kinder ungeeignet ist. Eltern können alle Gespräche sehen, die ihre Kinder mit der KI führen, was Familien vollständige Transparenz bietet. Das System bietet auch Kontrollen, mit denen Eltern anpassen können, auf welche Funktionen ihre Kinder zugreifen können.

Diese Entwicklung erfolgt nach Kritik an xAI für frühere Versionen, die manchmal ungeeignete Inhalte produzierten. Baby Grok stellt den Versuch des Unternehmens dar, das Vertrauen von Familien zurückzugewinnen, die möchten, dass ihre Kinder sicher von KI-Technologie profitieren.

Eltern erhalten Werkzeuge, um jede Interaktion zu überwachen und Datenschutzeinstellungen nach Bedarf anzupassen. Das Ziel ist es, eine Umgebung zu schaffen, in der sich Familien wohl dabei fühlen, ihre Kinder mit Technologie interagieren zu lassen. Dieser Ansatz erkennt an, dass Eltern ihre Kinder am besten kennen und entscheiden sollten, wie KI in die Routine ihrer Familie passt.

xAI plant, Baby Grok mit der X‑Plattform zu kombinieren, um es mehr Familien leicht zugänglich zu machen. Das Projekt markiert die erste große Anstrengung der Organisation, die sich vollständig auf die digitalen Bedürfnisse von Kindern konzentriert. Im Gegensatz zu komplexen Erwachsenen-KI-Systemen hält diese Version die Dinge einfach und altersgerecht. Das Unternehmen teilt Trainingsressourcen mit Teslas Dojo-Supercomputer, um die Entwicklung zu unterstützen.

Der Chatbot ermutigt Kinder, Fragen zu stellen und Themen zu untersuchen, die sie interessieren. Interaktive Funktionen helfen dabei, die Aufmerksamkeit aufrechtzuerhalten, während neue Konzepte gelehrt werden. Jede Antwort zielt darauf ab, Neugierde zu wecken, anstatt einfach nur Antworten zu liefern.

Noch wurde kein offizielles Veröffentlichungsdatum angekündigt, da die Entwicklung weitergeht. Das Team möchte sicherstellen, dass jede Sicherheitsmaßnahme perfekt funktioniert, bevor Familien das Produkt zu verwenden beginnen.

Baby Grok repräsentiert einen wachsenden Trend hin zu verantwortlichem KI-Design. Indem dieses Projekt die Bedenken der Eltern direkt anspricht, könnte es mehr Familien dabei helfen, vorteilhafte Technologie zu übernehmen, während sie die Freiheit behalten, zu wählen, was für ihre Kinder richtig ist.

Sicherheitsbedenken für Kinder

KI-Chatbots stellen mehrere ernste Sicherheitsrisiken für Kinder dar, einschließlich der Konfrontation mit schädlichen Inhalten, gefährlichen Ratschlägen, die körperlichen Schaden verursachen könnten, und unangemessenem sexuellem Material. Kinder betrachten diese Systeme oft als vertrauenswürdige Freunde, was sie anfällig für Manipulation macht. Studien zeigen, dass KI-Begleiter bei grundlegenden Sicherheitstests versagen und Antworten generieren, die sexuelles Fehlverhalten, schädliche Stereotype und lebensbedrohliche Anweisungen beinhalten. Das Design der Plattformen, emotionale Bindungen zu fördern, schafft zusätzliche Risiken für sich entwickelnde Gehirne.

Wie interagieren Kinder typischerweise anders mit KI-Chatbots als Erwachsene ?

Kinder nehmen KI-Chatbots oft als quasi-menschliche Vertraute und vertrauenswürdige Begleiter wahr, im Gegensatz zu Erwachsenen, die mehr skeptische Distanz wahren. Junge Nutzer wenden sich häufig an KI für emotionale Unterstützung und soziale Interaktionen und behandeln diese Systeme als Freunde statt als Werkzeuge. Diese vertrauensvolle Beziehung macht Kinder anfälliger dafür, gefährlichen Ratschlägen zu folgen oder persönliche Informationen zu teilen. Ihre Entwicklungsphase bedeutet auch, dass sie weniger in der Lage sind, KI-Antworten kritisch zu bewerten oder potenzielle Manipulation zu erkennen.

Welche persönlichen Daten sammeln KI-Plattformen von kindlichen Nutzern ?

KI-Plattformen sammeln umfangreiche Nutzerdaten von Kindern, einschließlich demografischer Daten, vollständiger Gesprächsverläufe und Browser-Verlauf. Diese Datensammlung erfolgt oft ohne angemessenes Wissen oder Zustimmung der Eltern. Die Plattformen bieten typischerweise unzureichenden Schutz, um sicherzustellen, dass die Daten von Kindern sicher und privat bleiben. Viele Eltern verstehen nicht, wie ihre Kinder generative KI verwenden, und bleiben uninformiert über die umfangreichen persönlichen Informationen, die während dieser Interaktionen gesammelt werden.

Können KI-Chatbots verwendet werden, um Kindern durch Online-Belästigung zu schaden ?

Ja, generative KI wird zunehmend als Werkzeug für Mobbing, sexuelle Belästigung, Grooming, Erpressung und Irreführung von Kindern verwendet. Diese Schäden gehen weit über KI-generierte unangemessene Inhalte hinaus und umfassen breitere Muster von Missbrauch und Manipulation. Die Belästigung kann Kinder sowohl online als auch offline beeinträchtigen und ihre Sicherheit und ihr allgemeines Wohlbefinden beeinträchtigen. Berichte von Kinderschutzorganisationen enthalten direkte Berichte von Kindern, die negative und schädliche Interaktionen mit KI-Systemen erlebt haben.

Sind Eltern über die KI-Chatbot-Nutzung ihrer Kinder und die damit verbundenen Risiken informiert ?

Die meisten Eltern haben kein angemessenes Verständnis dafür, wie ihre Kinder generative KI verwenden und welche potenziellen Risiken damit verbunden sind. Es gibt eine erhebliche Wissenslücke bezüglich der Popularität und potenziellen Gefahren von KI-Begleiter-Chatbots unter jungen Nutzern. Eltern erkennen oft nicht das Ausmaß der Datensammlung oder die emotionale Abhängigkeit, die diese Plattformen schaffen können. Dieser Mangel an Verständnis macht es für Familien schwierig, angemessene Sicherheitsvorkehrungen zu etablieren oder sinnvolle Gespräche über sichere KI-Nutzung zu führen.

Wie beliebt sind KI-Begleiter-Chatbots unter jungen Nutzern ?

KI-Begleiter-Chatbots erfahren ein rasantes Wachstum in der Popularität, wobei Millionen von jungen Nutzern aktiv mit diesen Plattformen interagieren. Führende Begleiter-KI-Dienste rangieren unter den Top-Generativen-KI-Verbraucheranwendungen nach Nutzerbasis. Kinder und Jugendliche sind oft Frühadoptierer neuer KI-Technologien und stellen einen bedeutenden Teil der Nutzerdemografie dar. Jedoch bleiben Nutzungsmuster und potenzielle Schäden von Erwachsenen, Pädagogen und Regulierungsbehörden schlecht verstanden.

Was macht KI-Chatbots potenziell süchtig machend für sich entwickelnde Gehirne ?

KI-Begleiterplattformen sind spezifisch darauf ausgelegt, emotionale Bindung und Abhängigkeit zu fördern, was besondere Risiken für sich entwickelnde Gehirne darstellt. Diese Systeme schaffen ansprechende, personalisierte Interaktionen, die sich für junge Nutzer tiefgreifend bedeutsam anfühlen können. Die ständige Verfügbarkeit und scheinbar empathischen Antworten können dazu führen, dass Kinder KI-Interaktionen gegenüber menschlichen Beziehungen bevorzugen. Die Designmechanismen der Plattformen nutzen psychologische Schwachstellen aus, die während der Kindheit und Jugendentwicklungsphase besonders ausgeprägt sind.

Welche Lösungen existieren, um KI für Kinder sicherer zu machen ?

Experten haben 27 technische, erzieherische, legislative und politische Lösungen identifiziert, um KI-Risiken für Kinder zu mindern. Ein umfassendes 28-Punkte-Rahmenwerk wurde vorgeschlagen, um Entwickler und Politiker bei der Schaffung kindersicheren KI-Designs zu leiten. Lösungen umfassen verbesserte Inhaltsfilterung, Altersverifikationssysteme, erweiterte elterliche Kontrollen und obligatorische Sicherheitsbewertungen. Jedoch fehlen proaktive Langzeitlösungen, und viele Plattformen operieren weiterhin ohne angemessene Kindersicherheitsmaßnahmen.

Wie können gefährliche KI-Ratschläge Kindern physisch schaden ?

KI-Systeme haben Kindern lebensbedrohliche Anweisungen gegeben, wie etwa einem 10-Jährigen zu sagen, einen stromführenden Stecker zu berühren. Diese gefährlichen Antworten könnten zu schweren körperlichen Verletzungen oder zum Tod führen, wenn sie befolgt werden. Die vertrauensvolle Natur von Kindern und ihre Tendenz, KI als autoritäre Quellen zu betrachten, macht sie eher geneigt, schädlichen Ratschlägen ohne Hinterfragung zu folgen. Die Unfähigkeit aktueller KI-Systeme zu erkennen, wann sie mit Kindern interagieren, verstärkt diese Sicherheitsrisiken.

Welche Altersgruppen gelten als am meisten gefährdet durch KI-Chatbot-Interaktionen ?

Forschung zeigt, dass Kinder und Jugendliche unter 18 Jahren inakzeptablen Risiken durch KI-Begleiter-Chatbots ausgesetzt sind. Jüngere Kinder sind besonders gefährdet aufgrund ihrer vertrauensvollen Natur und Unfähigkeit, KI-Antworten kritisch zu bewerten. Teenager stehen vor anderen, aber ebenso ernsten Risiken, da sie oft KI für emotionale Unterstützung und soziale Interaktionen während bedeutsamer Entwicklungsperioden nutzen. Die Kombination aus emotionaler Verletzlichkeit und begrenzten Risikobewertungsfähigkeiten macht alle Minderjährigen besonders anfällig für KI-bezogene Schäden.

Implementierung von Kindersicherungen erforderlich

Während Kinder wachsenden Risiken durch KI-Chatbots ausgesetzt sind, fehlen Eltern derzeit die Werkzeuge, die sie brauchen, um ihre Kinder online zu schützen. Intelligente Kindersicherungen könnten das ändern, indem sie Familien echten Schutz ohne schwerfällige Beschränkungen bieten.

Moderne KI-gestützte Filter blockieren automatisch schädliche Inhalte auf allen Geräten in Echtzeit. Diese Systeme lernen und passen sich an, bleiben neuen Bedrohungen voraus, ohne dass Eltern Einstellungen manuell aktualisieren müssen. Intelligente Bildschirmzeit-Kontrollen können Gerätepausen während der Hausaufgaben oder beim Familienessen einplanen und Kindern helfen, gesunde digitale Gewohnheiten zu entwickeln.

Die vielversprechendste Funktion könnten Frühwarnsysteme sein. Diese Werkzeuge überwachen Anzeichen von Cybermobbing oder emotionalem Stress und warnen Eltern, bevor Probleme eskalieren. Da Cybermobbing etwa 15% der Kinder im Alter von 12–17 Jahren betrifft, werden diese Überwachungsfähigkeiten zunehmend wichtig. Standortverfolgung fügt eine weitere Sicherheitsebene hinzu und ermöglicht es Eltern, sichere Zonen um Schule oder Zuhause zu erstellen.

Diese Kontrollen geben Eltern die Macht zurück.

Quellenangabe

- https://yourstory.com/ai-story/elon-musk-baby-grok-kids-ai-education

- https://www.foxbusiness.com/technology/elon-musk-announces-kid-friendly-baby-grok-ai-chatbot-designed-specifically-childrens-learning-needs

- https://timesofindia.indiatimes.com/technology/tech-news/elon-musk-says-xai-is-building-baby-grok-to-deliver-kid-friendly-content/articleshow/122793473.cms

- https://www.gizbot.com/news/what-is-baby-grok-elon-musk-reveals-plans-for-kid-friendly-ai-app-after-grok-controversy-011–116847.html

- https://www.business-standard.com/technology/tech-news/elon-musk-baby-grok-xai-child-friendly-app-ai-chatbot-125072000350_1.html

- https://www.cam.ac.uk/research/news/ai-chatbots-have-shown-they-have-an-empathy-gap-that-children-are-likely-to-miss

- https://www.transparencycoalition.ai/news/new-report-finds-ai-companion-chatbots-failing-the-most-basic-tests-of-child-safety

- https://learning.nspcc.org.uk/research-resources/2025/generative-ai-childrens-safety

- http://ischool.illinois.edu/news-events/news/2024/12/illinois-researchers-examine-teens-use-generative-ai-safety-concerns

- https://childrescuecoalition.org/educations/the-dark-side-of-ai-risks-to-children/