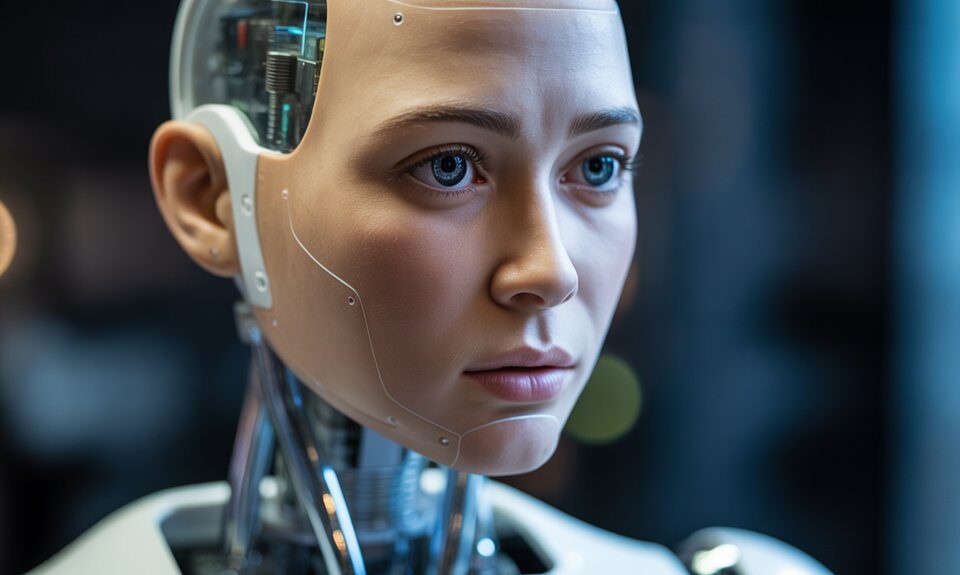

Einführung in AutoGPT

29/04/2023

ChatGPT Prompt für einen vollständig SEO-optimierten Artikel mit FAQ’s

30/04/2023GPT‑5 wird möglicherweise nicht auf einmal veröffentlicht.

Eines der Hauptprobleme bei KI-Modellen wie GPT‑4 von OpenAI ist die Zuverlässigkeit.

Abgesehen davon, dass es gelegentlich falsche Antworten gibt, hat ChatGPT in den letzten Wochen für Aufregung gesorgt.

- Experten warnen, dass es gegen die GDPR und DSGVO verstoßen könnte, weshalb Italien kürzlich ChatGPT zeitweise verboten hatte.

- ChatGPT hat Berichten zufolge auch streng geheime Daten von Samsung weitergegeben, nachdem Mitarbeiter die KI zur “Optimierung” von Quellcodes eingesetzt hatten.

Diese Kontroversen haben zahlreiche Branchenführer dazu veranlasst, einen dringenden Aufruf zum Stopp von KI-Experimenten jenseits von GPT‑4 zu machen.

Die Reaktion von OpenAI auf die Situation

In einem kürzlichen Tweet schlug OpenAI-Mitbegründer Greg Brockman vor, dass die schrittweise Veröffentlichung weiterer Checkpoints anstelle einer großen Version alle 12 Monate ein besser zu handhabender und sicherer Ansatz ist.

Der Grundgedanke vieler Debatten über das Tempo des KI-Fortschritts – dass wir die Sicherheit sehr ernst nehmen und mit Vorsicht vorgehen müssen – ist der Schlüssel zu unserer Mission. Wir haben mehr als 6 Monate damit verbracht, GPT‑4 zu testen und es noch sicherer zu machen, und haben es auf jahrelanger Anpassungsforschung aufgebaut, die wir in Erwartung von Modellen wie GPT‑4 betrieben haben.

Wir gehen davon aus, dass wir unsere Sicherheitsvorkehrungen weiter ausbauen werden, und zwar proaktiver, als es viele unserer Nutzer/innen wünschen. Unser allgemeines Ziel ist es, dass jedes Modell, das wir ausliefern, unser bisher am besten ausgerichtetes Modell ist, und das war bisher bei GPT‑3 (das ursprünglich ohne besondere Ausrichtung eingesetzt wurde), GPT‑3.5 (ausreichend ausgerichtet, um in ChatGPT eingesetzt zu werden) und jetzt GPT‑4 (das bei allen unseren Sicherheitsmetriken viel besser abschneidet als GPT‑3.5) der Fall.

Wir sind der Meinung (und haben dies auch in politischen Diskussionen mit Regierungen zum Ausdruck gebracht), dass leistungsstarke Trainingsläufe den Regierungen gemeldet werden sollten, dass sie von immer ausgefeilteren Vorhersagen über ihre Fähigkeiten und Auswirkungen begleitet werden sollten und dass Best Practices wie gefährliche Fähigkeitstests erforderlich sind.

Wir sind der Meinung, dass die Steuerung der Computernutzung in großem Maßstab, Sicherheitsstandards und die Regulierung des Einsatzes bzw. des Austauschs von Erfahrungen gute Ideen sind, aber die Details sind wirklich wichtig und sollten im Laufe der Zeit angepasst werden, wenn sich die Technologie weiterentwickelt. Außerdem ist es wichtig, das gesamte Spektrum der Risiken zu berücksichtigen, von aktuellen Fragen (z. B. Verhinderung von Missbrauch oder Selbstbeschädigung, Abschwächung von Vorurteilen) bis hin zu längerfristigen existenziellen Risiken.

Das vielleicht häufigste Thema in der langen Geschichte der KI sind falsche, zuversichtliche Vorhersagen von Experten. Eine Möglichkeit, unentdeckte Vorhersagefehler zu vermeiden, besteht darin, dass die Technologie in ihrem aktuellen Zustand frühzeitig und häufig mit der Realität in Berührung kommt, während sie iterativ entwickelt, getestet, eingesetzt und ständig verbessert wird. Und es gibt kreative Ideen, über die nicht oft gesprochen wird und die die Sicherheitslandschaft auf überraschende Weise verbessern können.

So ist es zum Beispiel einfach, ein Kontinuum schrittweise verbesserter KI zu schaffen (z. B. durch den Einsatz nachfolgender Kontrollpunkte eines bestimmten Trainingslaufs), was eine Sicherheitschance darstellt, die sich von unserem bisherigen Ansatz der seltenen großen Modell-Upgrades stark unterscheidet.

Der bevorstehende technologische Wandel der KI ist ein Grund für Optimismus und Besorgnis zugleich – die ganze Bandbreite der Emotionen ist berechtigt und wird auch von den Menschen bei OpenAI geteilt. Es ist eine besondere Chance und Verpflichtung für uns alle, in dieser Zeit zu leben und die Zukunft gemeinsam gestalten zu können.

Nur um das klarzustellen : Er spricht nicht jedes Mal von neuen und anderen Modellen. Stattdessen stellt ein Kontrollpunkt während des GPT-5-Trainings eine Momentaufnahme der aktuellen Parameterwerte des Modells dar.

Bei einem späteren Checkpoint werden die Parameter aktualisiert, wenn das Modell mehr Daten verarbeitet oder aufgrund von Nutzerfeedback optimiert wird.

Deutet dies darauf hin, dass OpenAI die fehlenden Sicherheitsvorkehrungen für die Nutzer/innen anerkennt ?

Was hältst du von der Strategie von OpenAI ? Stimmst du ihr zu ?

Microsoft will eine schnellere Freigabe von KI durchsetzen

Trotz der Aufforderung prominenter Tech-Persönlichkeiten, KI-Experimente zu stoppen, drängt Microsft-CEO Satya Nadella auf eine schnellere Veröffentlichung von KI-Modellen.

Microsoft will die Veröffentlichung neuer KIs beschleunigen

Auf die Frage nach der strategischen Bedeutung von KI-Fortschritten während seiner neunjährigen Amtszeit als CEO antwortete Nadella, dass man die Wellen des Wandels erkennen und die Technologie- und Innovationsagenda entsprechend neu ausrichten muss, um im Technologiebereich relevant zu bleiben.

Ist seine Sorge um die Sicherheit von KI echt, oder versucht er einfach, sich einen Wettbewerbsvorteil gegenüber der Konkurrenz zu verschaffen ?

Für diejenigen, die es noch nicht wissen : Microsoft hat letzten Monat sein gesamtes KI-Ethikteam entlassen.

Ich persönlich stimme Greg zu, dass es besser ist, sich für kleine, schrittweise Veröffentlichungen zu entscheiden als für große.

Die KI-Entwicklung zu stoppen ist keine gute Idee. Selbst Bill Gates hält diesen Schritt für unpraktisch. Stattdessen schlug er vor, sich darauf zu konzentrieren, wie man die Entwicklungen am besten nutzt und “die kniffligen Bereiche zu identifizieren.”

Ich hoffe, dass OpenAI nicht zu sehr unter Druck steht, Gewinn zu machen, nachdem Microsoft eine Investition von 10 Milliarden Dollar getätigt hat.